от фальшпола до погружения в масло

Система охлаждения в серверной забирает на себя до 40% энергоресурсов. Это серьезные издержки для любой компании. В этой статье мы постараемся рассказать, какие варианты кондиционирования существуют, какие новые технологии появляются на рынке, помогающие снизить затраты на эксплуатацию подобных систем.

По данным агентства Spiceworks, опросившего более тысячи европейских и американских компаний, крупные бренды львиную долю своего hardware-бюджета в 2018 году собираются потратить на оптимизацию систем энергоснабжения и охлаждения серверных.

Для многих предприятий вопрос сокращения потребления электроэнергии является критическим. Дата-центр потребляет огромное количество энергии, и этот показатель в течение 10 лет грозит увеличиться втрое. Учитывая ежегодный рост тарифов минимум на 10%, проблема серьезная. Причем от 30 до 40% энергии в стандартной серверной комнате уходит именно на охлаждение.

Новые технологии, появившиеся на рынке в последние несколько лет, позволяют сократить энергопотребление серверных в разы. Для примера, большие ЦОД в среднем забирают до 100 млрд. кВт в год, при этом 30% серверов трудятся вхолостую. Если даже повысить эффективность на 20%, получается экономия в 20 млрд. кВт, по ценам американского рынка электроэнергии это примерно 2 млрд. долларов.

Для примера, большие ЦОД в среднем забирают до 100 млрд. кВт в год, при этом 30% серверов трудятся вхолостую. Если даже повысить эффективность на 20%, получается экономия в 20 млрд. кВт, по ценам американского рынка электроэнергии это примерно 2 млрд. долларов.

Тренды в обустройстве дата-центров 2018 года

Прежде чем перейти к обзору новых технологий в области охлаждения серверных комнат, пара замечаний по поводу трендов в организации ЦОД на предприятии. По большому счету, классический дата-центр компании, когда все вычисления происходят в одном месте, сегодня это устаревшее явление.

В моде децентрализация. Мы уже писали про популярность гибридной модели ИТ-инфраструктуры предприятия, позволяющей совмещать удобство облачных сред, контроль и безопасность, предоставляемые традиционными сетями.

Большинство западных компаний, вне зависимости от размера и сферы деятельности, предпочитают часть важных данных и корпоративных приложений оставлять у себя, а часть вычислений передавать в облако. В чистом виде локальные сети (on premises) больше практически нигде не встречаются. Этот фактор необходимо учитывать при построении собственного мини дата-центра.

В чистом виде локальные сети (on premises) больше практически нигде не встречаются. Этот фактор необходимо учитывать при построении собственного мини дата-центра.

По утверждению издания Data Centre Knowledge, 2018 пройдет под знаком «периферийных» дата-центров. Периферийные вычисления ни завтра, ни послезавтра не смогут полностью заменить облако. Но подобные решения уже органично дополняют традиционные дата-центры и облачные сервисы в инфраструктуре многих компаний. Они используются для того чтобы разнести географически вычислительные мощности ближе к источникам данных с помощью так называемых микро дата-центров или хабов.

Считается, что все больше вычислительных ресурсов переходят к оконченным устройствам, составляющим мир «интернета вещей»: беспилотные автомобили, дроны и т.д. На данный момент 10% всей генерируемый компаниями цифровой информации обрабатывается за пределами традиционных централизованных дата-центров или облака. К 2020 году, по мнению Gartner, этот показатель достигнет 50%.

Варианты систем охлаждения для серверных

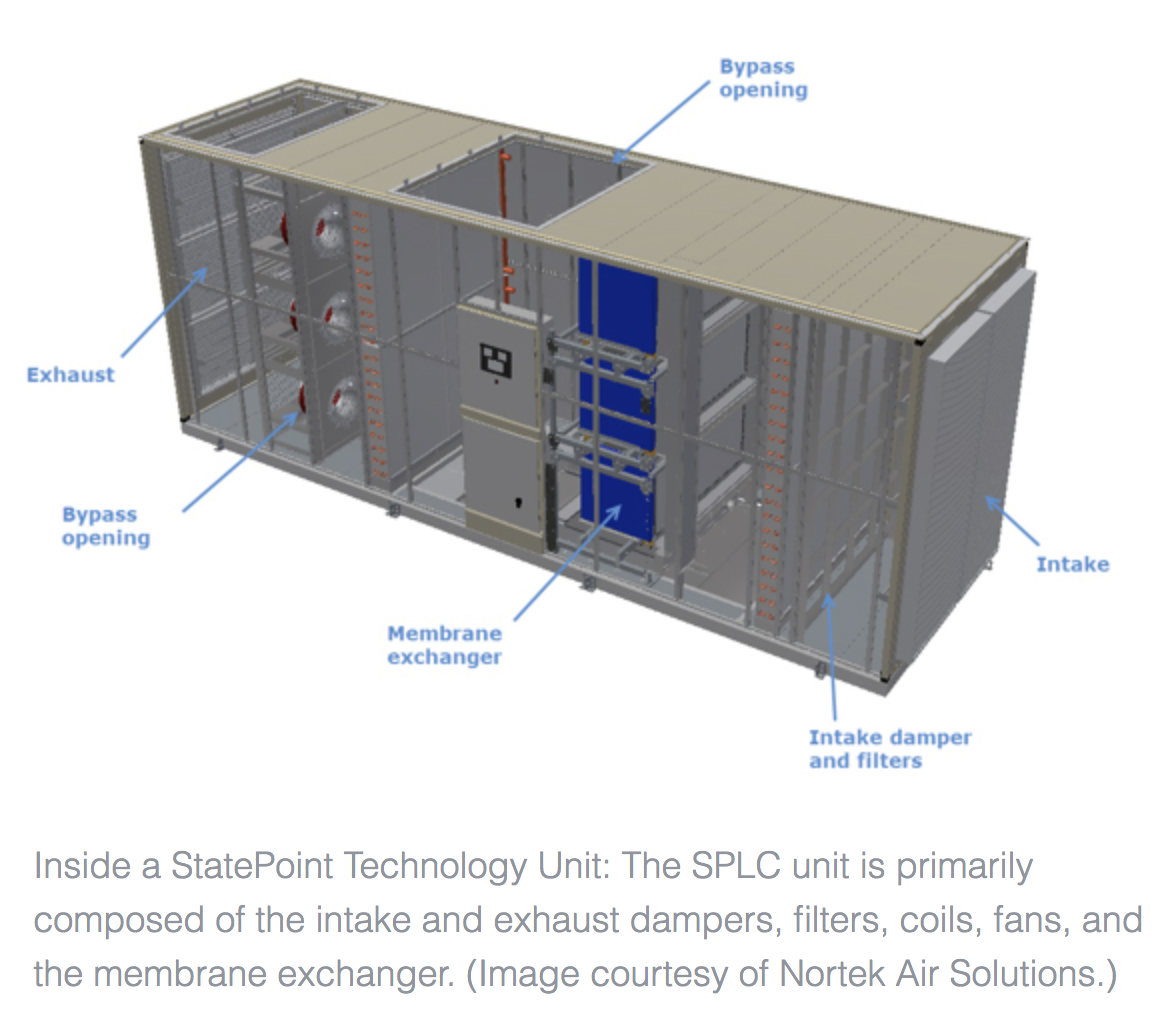

Десятилетиями в серверных комнатах использовалась система воздушного кондиционирования, где были оборудованы стойки, холодные и горячие коридоры и фальшпол. Воздух здесь прокачивается с помощью бытового или высокоточного (прецизионного) кондиционера, сделанного под параметры конкретного помещения.

Бытует мнение, что для системы серверов мощностью до 5 кВт отдельная серверная – лишние траты. Все оборудование можно утрамбовать в одну стойку и оставить ее в углу рабочего помещения. Для системы до 10 кВт достаточно бытового кондиционера. Это выглядит разумным, пока не берутся в расчет убытки от простоев, потери данных при сбоях в отсутствии регулярных бэкапов.

Система традиционного кондиционирования с фальшполом

В современном дата-центре практически невозможно встретить систему охлаждения в виде фальшпола (для него, кстати, критически важна высота полотков) и компрессорных кондиционеров, где горячий воздух переносится от внутреннего блока во внешнюю среду. Это экономически чрезвычайно затратно при большой плотности оборудования.

Это экономически чрезвычайно затратно при большой плотности оборудования.

Сам процесс охлаждения в серверной комнате или мини дата-центре можно разделить на несколько частей:

- Охлаждение серверов.

- Охлаждение помещение.

- Выведение горячего воздуха за пределы помещения.

Современные решения являются комбинацией различных систем (воздушное, жидкостное охлаждение). Кондиционеры могут быть установлены на каждый серверный шкаф, сервер или даже процессор могут охлаждаться отдельно.

Есть варианты прямого (direct) и непрямого (indirect) кондиционирования. Второй обычно применяется в условиях, когда крайне нежелательно смешение воздуха в помещении с воздухом с улицы (загрязнение, насекомые и т.д.). В этом случае воздух перемещается по закрытой петле, отработанные потоки охлаждаются жидкостью (вода, этиленгликоль).

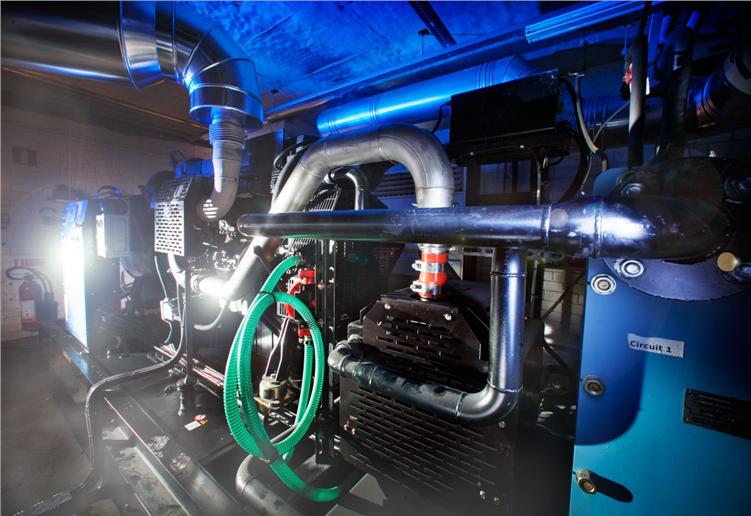

Считается, что системы жидкостного охлаждения более экологичны и экономичны. Экономия здесь идет за счет низкой стоимости хладагента, плюс такую систему легко масштабировать. По прогнозам, рынок жидкостных систем кондиционирования в мировом масштабе вырастет к 2020 году на 16%.

По прогнозам, рынок жидкостных систем кондиционирования в мировом масштабе вырастет к 2020 году на 16%.

Погружение в масло

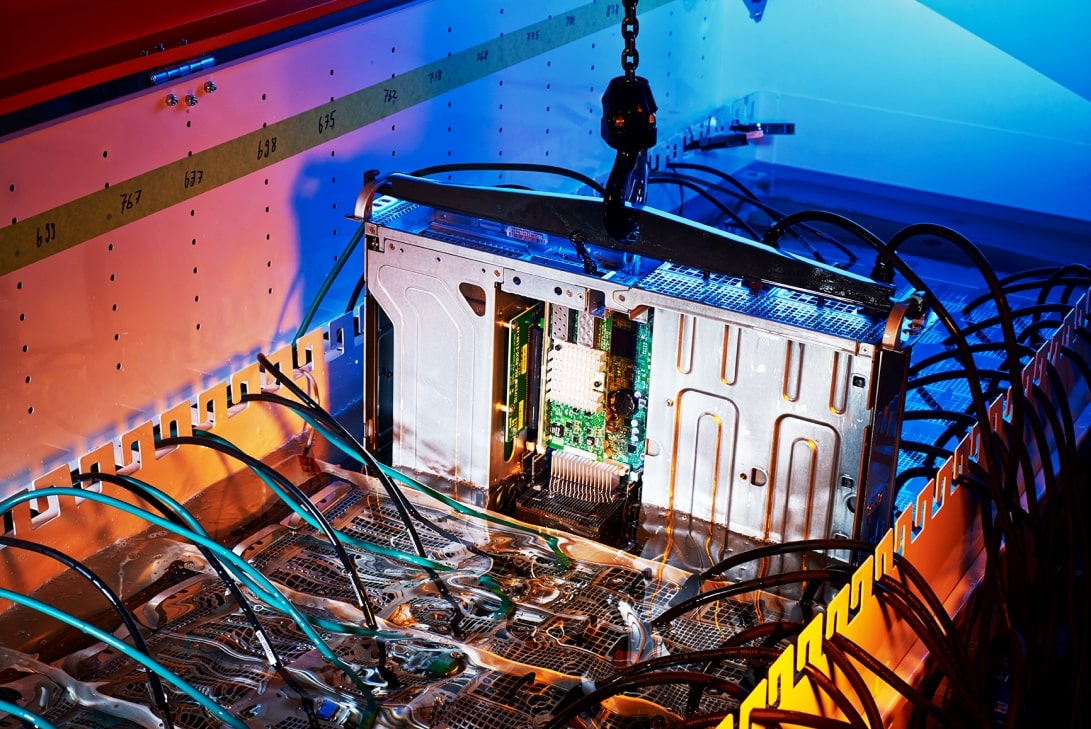

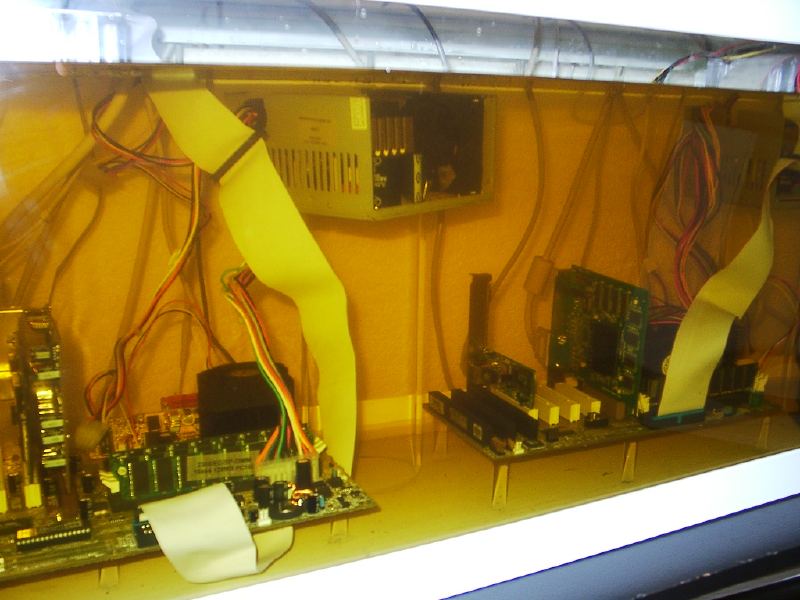

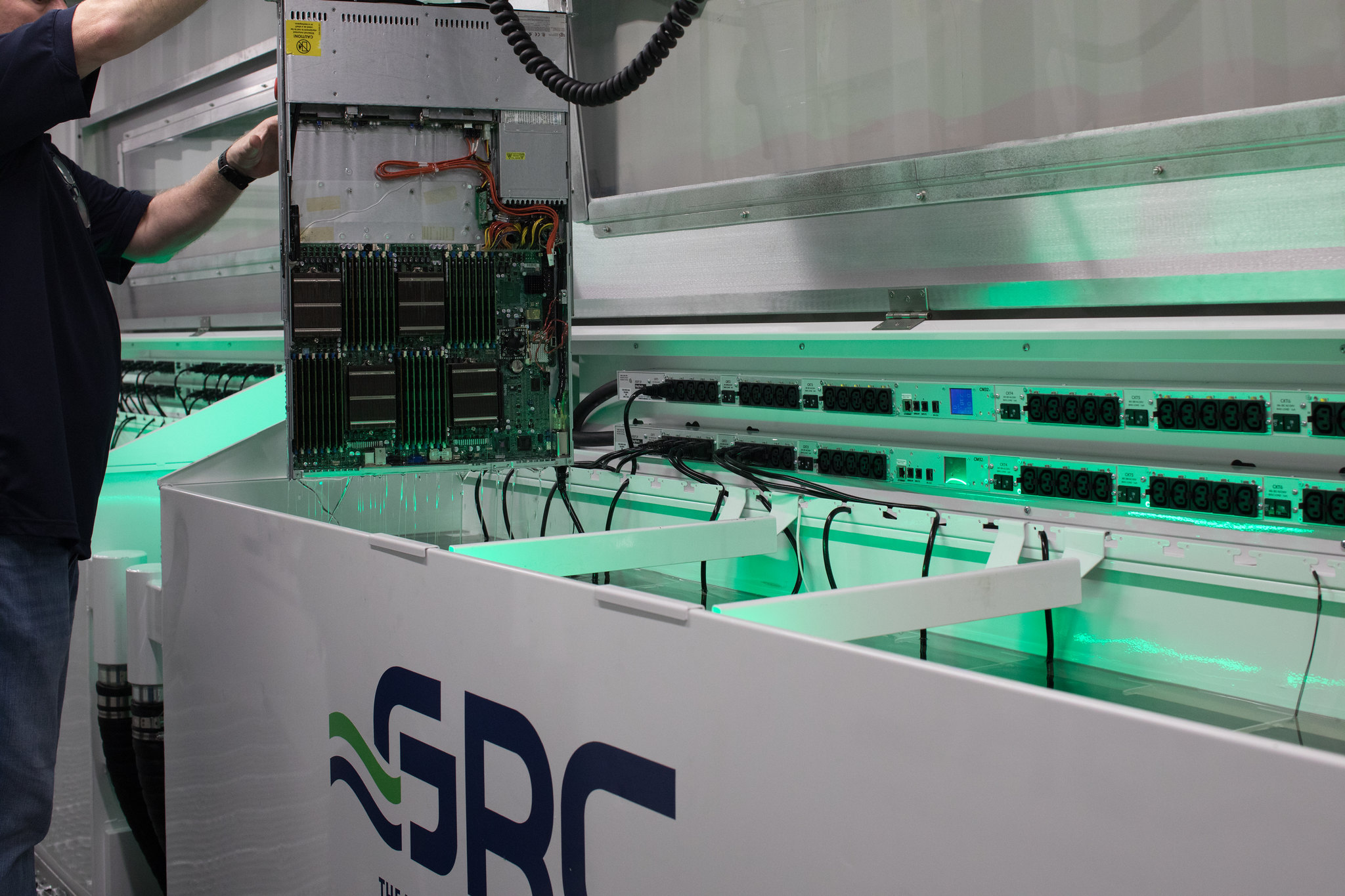

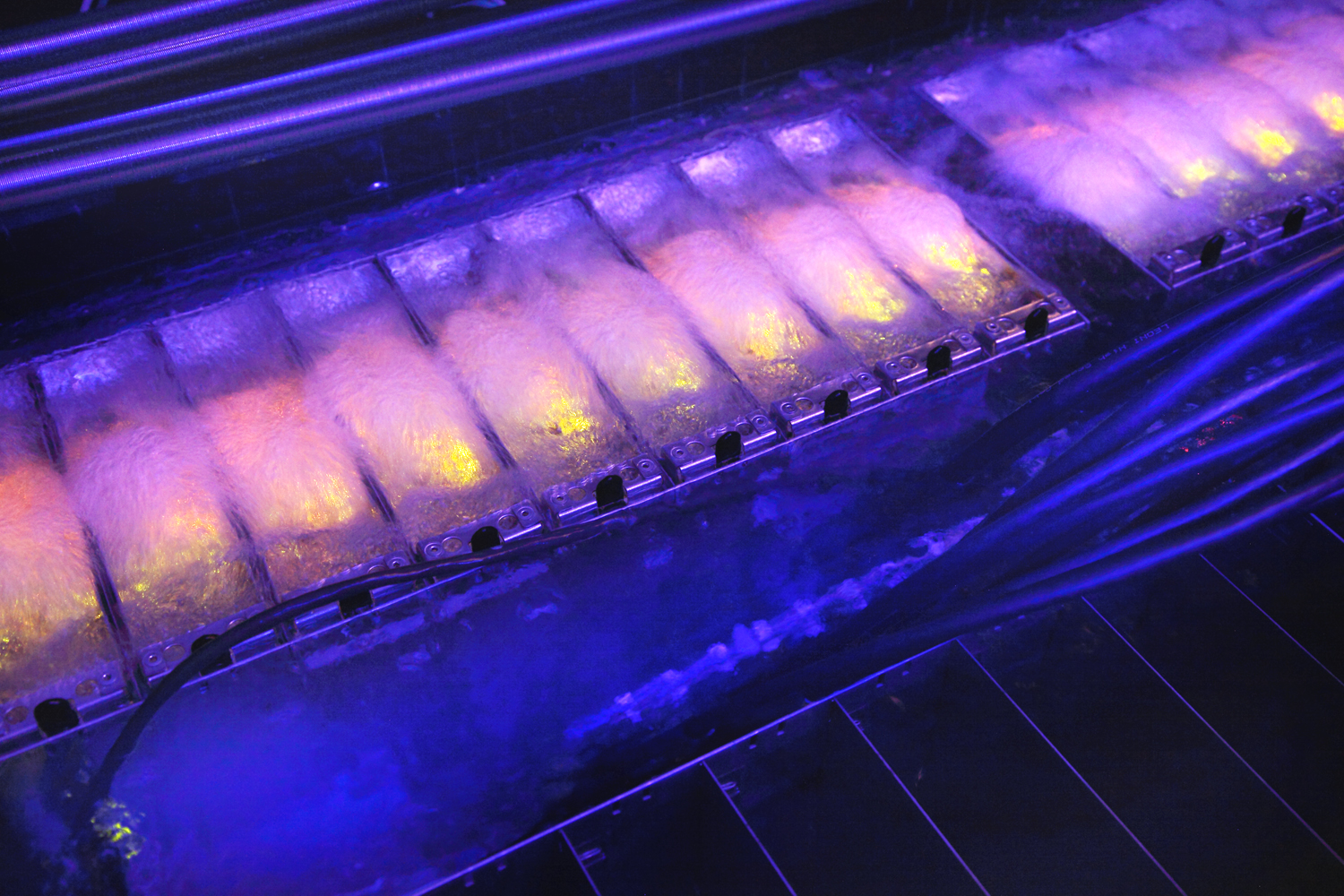

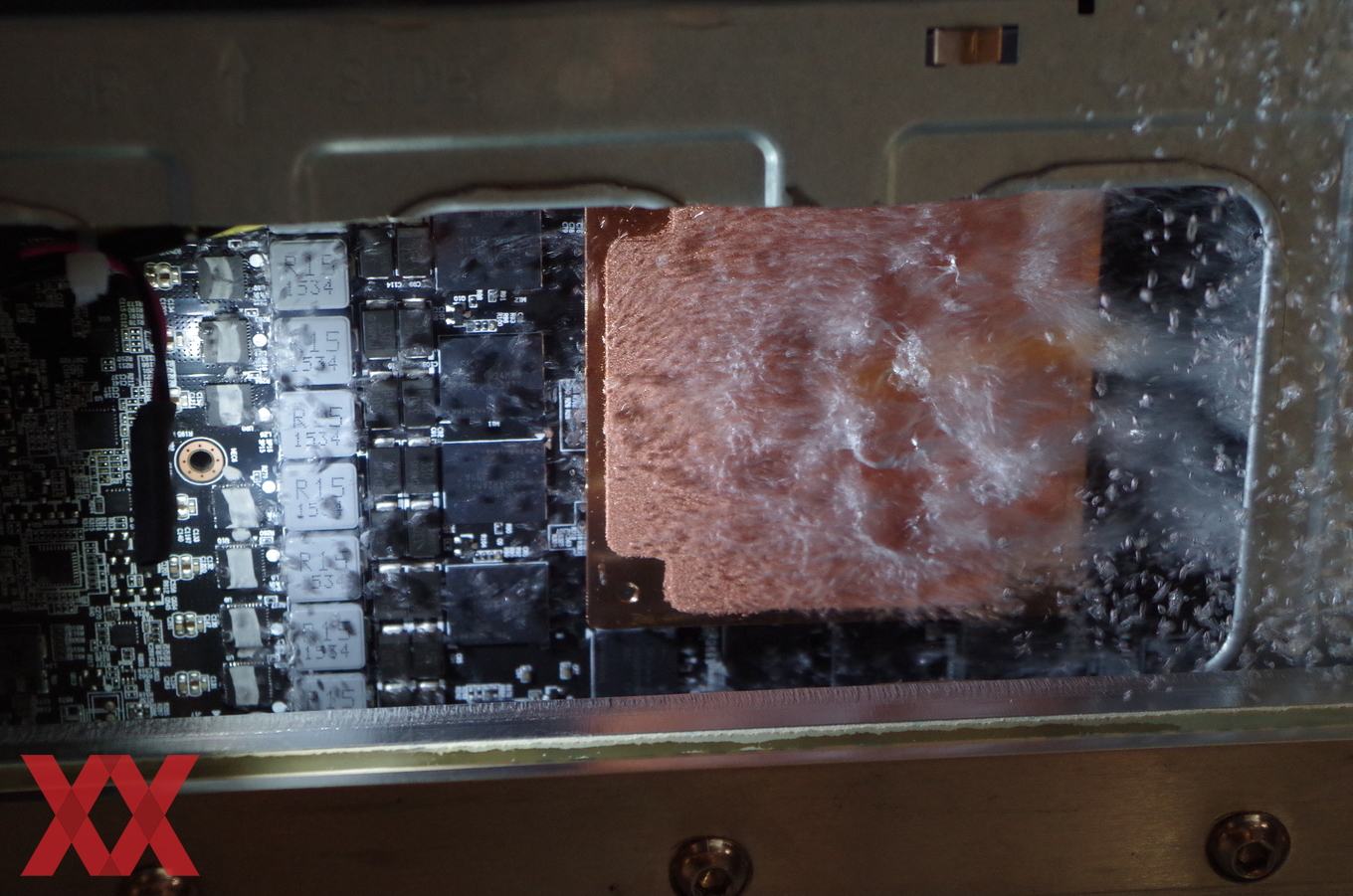

Новая продвинутая технология иммерсионного охлаждения серверов с помощью минерального масла была представлена на саммите OpenStack в ноябре прошлого года. Данный метод охлаждения не нов, он уже применяется в электрических трансформаторах и промышленных конденсаторах.

Во-первых, масло не проводит электричества, поэтому проблема возможных протечек решается сама собой. Во-вторых, это один из самых энергоэффективных вариантов. Масло обладает более высокой теплопроводностью, помогая лучше поглощать тепло и выводить его избытки.

В-третьих, как утверждают разработчики, такие системы готовы работать в экстремальных условиях даже на улице без постоянного контроля влажности и кондиционирования воздуха. Да и потом вода для охлаждения тоже в большинстве стран мира становится дефицитным ресурсом.

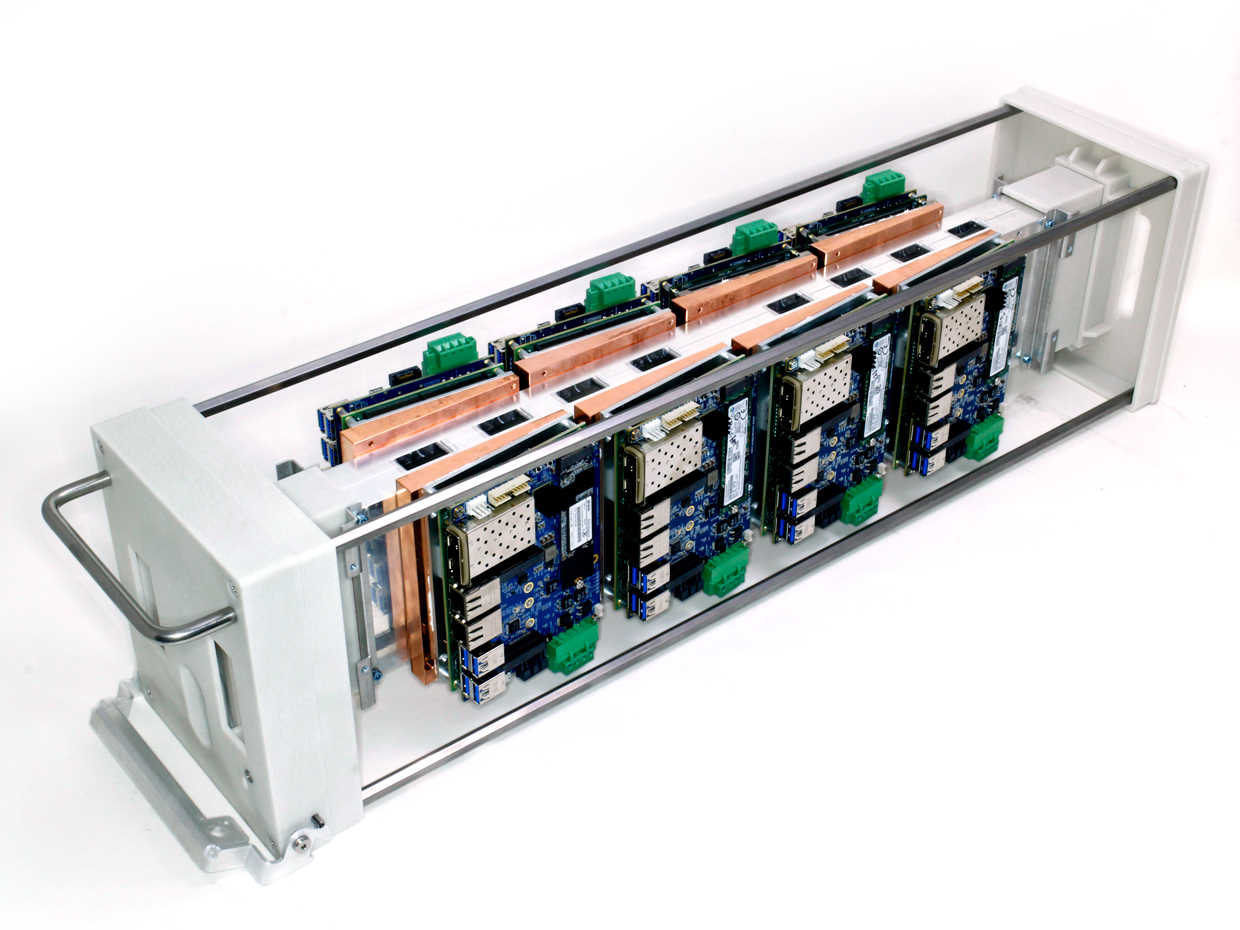

Подобное решение представила компания Horizon Computing. Их системы является, по сути, частью модульного дата-центра и представляют собой алюминиевый корпус размером 70x70x70 см, внутри которого могут располагаться четыре материнских платы microATX или восемь mini-ITX. Он заполнен специальным маслом, в который погружено оборудование. Правильная температура обеспечивается конвекцией радиатора.

Их системы является, по сути, частью модульного дата-центра и представляют собой алюминиевый корпус размером 70x70x70 см, внутри которого могут располагаться четыре материнских платы microATX или восемь mini-ITX. Он заполнен специальным маслом, в который погружено оборудование. Правильная температура обеспечивается конвекцией радиатора.

Предположим, что процессор работает на полной мощности при температуре воздуха 32°С, его средняя температура составит 85°С. При наличие масла с температурой 34°С, средняя температура ЦП упадет ниже 65°С. При этом поддержание температурного режима в масляной ванне на уровне 34°C требует значительно меньше энергии, чем поддержание температуры воздуха в пределах 32°C. Система также позволяет довести плотность размещения компонентов в одной стойке до 65 кВт.

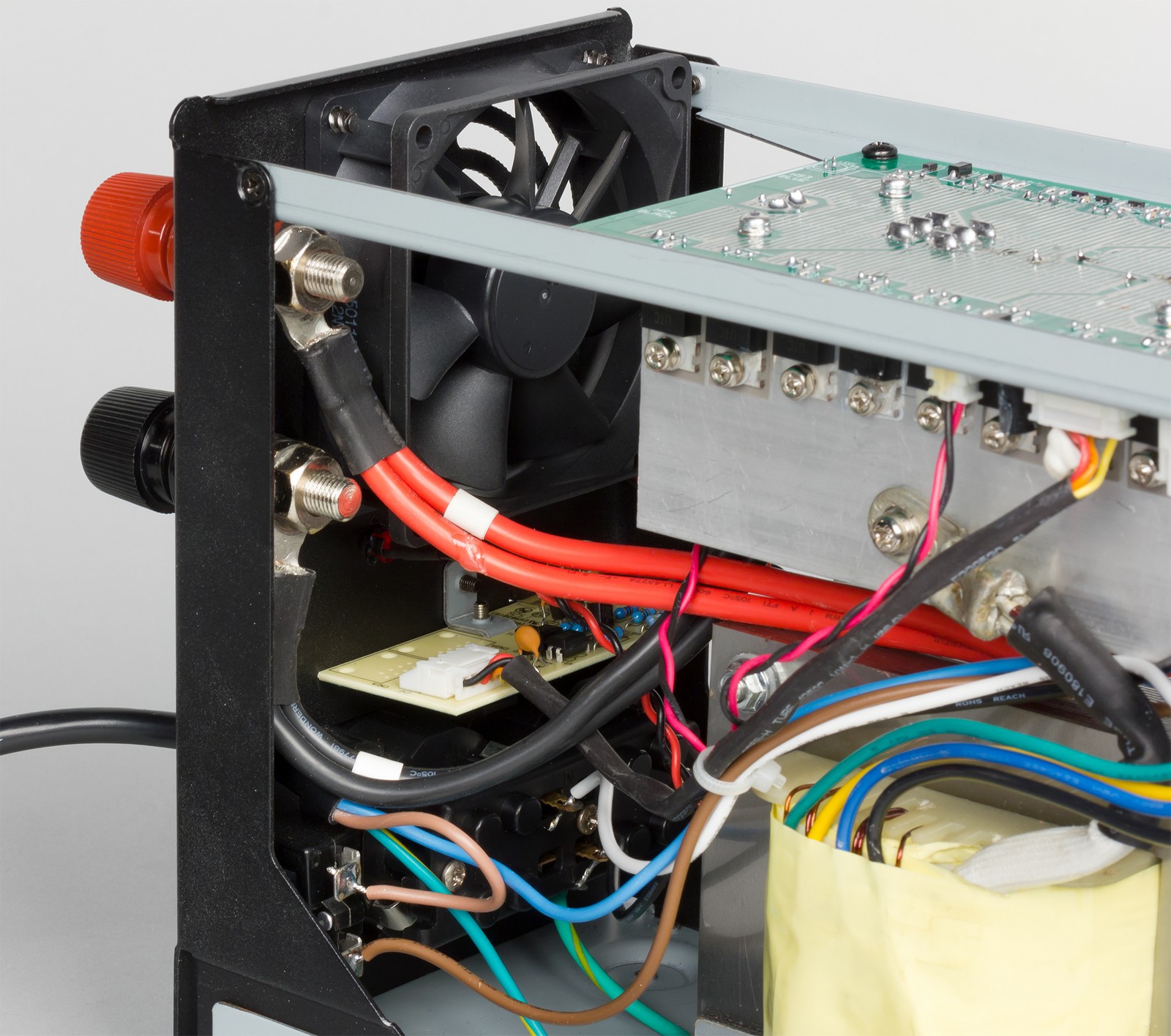

Компактные модули на литиевых батареях

Еще один революционный вариант, способный обеспечить энергоэффективность охлаждения серверных, представила недавно компания Teslamiser. Традиционный подход базируется на непрерывных источниках энергоснабжения (UPS) от стационарных генераторов или свинцово-кислотных аккумуляторных батарей. Это дорого с точки зрения как капитальных, так и операционных издержек.

Традиционный подход базируется на непрерывных источниках энергоснабжения (UPS) от стационарных генераторов или свинцово-кислотных аккумуляторных батарей. Это дорого с точки зрения как капитальных, так и операционных издержек.

Новый подход основывается на применении компактных модулей, источников питания для охладителей. Компания предлагает использовать литиевые батареи, наподобие тех, что установлены на автомобилях Tesla. В комплекте идет система мониторинга, способная обеспечить резервное питание при отключении электричества и оптимизировать расходование энергии.

По утверждению разработчиков, подобный резервный модуль может быть установлен на любой бытовой или промышленный кондиционер или систему с переменным током высокого напряжения.

Проектирование и установка системы охлаждения серверной комнате в каждом отдельном случае это индивидуальное решение. Серьезный фактор – климатические условия региона, а также плотность оборудования.

По классификации AFCOM, показатель плотности размещения 8 кВт на стойку уже считается достаточно высоким. В этом случае простым фрикулингом не обойтись, по крайней мере, в теплые периоды. Необходимо будет устанавливать компрессионные или жидкостные кондиционеры и оборудовать систему воздухоотвода.

В этом случае простым фрикулингом не обойтись, по крайней мере, в теплые периоды. Необходимо будет устанавливать компрессионные или жидкостные кондиционеры и оборудовать систему воздухоотвода.

Система мониторинга (в идеале охлаждение и энергопотребление должно контролироваться одной программой) для сложных комбинированных систем также является непременным условием их нормального функционирования.

Материал оказался полезным? Поделитесь с друзьями:Стратегии охлаждения для серверных и небольших помещений | Журнал сетевых решений/LAN

В архитектуре ЦОД и больших компьютерных залов всегда предусматривается система охлаждения. При этом многие ИТ-устройства по-прежнему располагаются за пределами машинных залов в локальных серверных, филиалах и других местах, при проектировании которых никаких требований к охлаждению оборудования не предъявлялось. Плотность размещения ИТ-оборудования со временем увеличивается, а в результате распределенное ИТ-оборудование (маршрутизаторы VoIP, коммутаторы и серверы) преждевременно выходит из строя из-за перегрева.

Плотность размещения ИТ-оборудования со временем увеличивается, а в результате распределенное ИТ-оборудование (маршрутизаторы VoIP, коммутаторы и серверы) преждевременно выходит из строя из-за перегрева.

Как правило, эти вопросы попросту игнорируются: организации начинают предпринимать необходимые меры только при возникновении проблем. Однако все больше и больше пользователей находят такой подход неудовлетворительным и требуют более активных действий по обеспечению должного уровня готовности распределенного ИТ-оборудования. Ниже излагаются основные принципы охлаждения небольших распределенных ИТ-сред и даются рекомендации по выработке эффективных спецификаций и проектированию вспомогательных систем охлаждения.

ПРИЕМЛЕМАЯ РАБОЧАЯ ТЕМПЕРАТУРА В СЕРВЕРНЫХ

Чтобы правильно подобрать решение для охлаждения серверной, сначала необходимо определить температуру, при которой будет функционировать оборудование в этом помещении. Поставщики обычно указывают максимальную температуру окружающей среды, при которой оно способно работать: для активного ИТ-оборудования средний показатель составляет 40°C (речь идет о температуре, при которой поставщик может обеспечить должную производительность и устойчивость работы своих устройств в течение гарантийного периода).

При этом необходимо помнить, что функционирование в таких условиях не обеспечивает такого же уровня готовности и долговечности, как при более низких температурах. Именно поэтому некоторые поставщики, помимо максимальной, указывают также рекомендованную рабочую температуру. Обычно она составляет от 21 до 24°C.

Рекомендованную и разрешенную для ИТ-оборудования рабочую температуру публикует также технический комитет TC 9.9 Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigeration, and Air Conditioning Engineers, ASHRAE). Цель заключается в том, чтобы предоставить ориентир для обеспечения необходимой устойчивости и производительности аппаратных средств. Соответствующие показатели представлены в табл. 1.

| Таблица 1. Ограничения рабочей температуры ASHRAE TC 9.9 |

Температуру следует поддерживать не выше 25°C.

Особое внимание следует уделить серверным с установленными в них источниками бесперебойного питания (ИБП). Повышение температуры гораздо сильнее влияет на долговечность батарей, чем на другие типы ИТ-оборудования. При 40°C батарея типового ИБП проработает всего 1,5 года, тогда как в нормальных рабочих условиях — 3–5 лет. Поэтому обязательным требованием должна стать температура ниже 25°C. Альтернативным вариантом может быть размещение централизованных ИБП в хорошо охлаждаемом месте за пределами серверной.

ОСНОВНЫЕ ПРИНЦИПЫ ОТВОДА ТЕПЛА

Для лучшего понимания сути вопроса полезнее было бы сформулировать его по-другому — с точки зрения отвода тепла, а не подачи холодного воздуха. Если тепло не отводить, оно будет накапливаться во всех замкнутых пространствах, где находится оборудование, а значит, температура станет повышаться. Каждый киловатт потребляемой ИТ-оборудованием электроэнергии создает киловатт тепла, которое необходимо отвести.

Если тепло не отводить, оно будет накапливаться во всех замкнутых пространствах, где находится оборудование, а значит, температура станет повышаться. Каждый киловатт потребляемой ИТ-оборудованием электроэнергии создает киловатт тепла, которое необходимо отвести.

Тепло можно сравнить с предметом, который катится вниз. Оно передается от объекта или среды с более высокой температурой к объекту или среде, у которых температура ниже. Чтобы отвести тепло, его нужно направить в более холодное место. Во многих реальных ситуациях такая возможность отсутствует.

Тепло может покинуть небольшое замкнутое пространство, каковым являются офис или серверная, пятью различными способами:

- Естественная теплопроводность. Тепло уходит через стены во внешнюю среду.

- Пассивная вентиляция. Тепло уходит в более холодную среду через вентиляционное отверстие или решетку без применения вентилятора.

- Принудительная вентиляция.

Тепло отводится с помощью вентилятора в более холодную среду через вентиляционное отверстие или решетку.

Тепло отводится с помощью вентилятора в более холодную среду через вентиляционное отверстие или решетку. - Климат-контроль. Тепло удаляется с помощью охлаждающих систем здания.

- Выделенная система охлаждения. Тепло отводится с помощью специального кондиционера.

Пять перечисленных методов имеют разные эффективность, ограничения и стоимость. Пользователи должны понимать, какой метод используется или предлагается в конкретной ситуации, какой больше подходит с учетом существующих ограничений и предпочтений и как должны определяться требования к проекту.

На рис. 1 представлена общая схема для стратегии охлаждения в зависимости от текущей и целевой температуры в зале при обычных условиях. На ней показаны диапазоны производительности для различных методов. Не надо пытаться перевести эти ограничения в абсолютные цифры, поскольку стратегии перекрываются, а окончательное решение должно учитывать все факторы, от которых зависит степень охлаждения. Системы климат-контроля здесь не представлены, поскольку они могут быть очень разными, а их функционирование — непредсказуемым. Ниже мы рассмотрим этот вопрос более подробно.

Системы климат-контроля здесь не представлены, поскольку они могут быть очень разными, а их функционирование — непредсказуемым. Ниже мы рассмотрим этот вопрос более подробно.

| Рис. 1. Сопоставление методов охлаждения в зависимости от энергопотребления и целевой температуры в зале |

ЕСТЕСТВЕННАЯ ТЕПЛОПРОВОДНОСТЬ: ТЕПЛО УХОДИТ ЧЕРЕЗ СТЕНЫ

В закрытых подсобных помещениях, которые встречаются довольно часто, единственным способом отвода тепла является кондуктивный теплообмен через стены. Чтобы этот метод работал, воздух внутри помещения должен быть более теплым, чем снаружи. Причем температура в нем растет тем сильнее, чем выше уровень энергопотребления работающего ИТ-оборудования.

Рис. 2. Зависимость температуры в серверной от уровня энергопотребления ИТ-оборудования. Эффективность естественной теплопроводности Эффективность естественной теплопроводности |

Пример соотношения между средней температурой в серверной (в предположении ее равномерного распределения) и энергопотреблением оборудования приведен на рис. 2. Данное соотношение предполагает наличие закрытого помещения размером 3 × 3 × 3 м с утечкой воздуха со скоростью 23,6 л в секунду, стенами из гипсокартона и комфортным охлаждением снаружи до уровня 20°C (см. подробнее врезку «Предполагаемые условия для типовой серверной»).

Предполагаемые условия для типовой серверной

Для описания типовой серверной обычно используется экстенсивная модель, учитывающая теплопроводность стен, конвекцию и излучение. Под конвекцией понимаются естественный теплообмен со стенами комнаты и заданный воздушный поток (в результате утечки воздуха). Предположения об условиях в «типовой» серверной приведены ниже.

| Параметры типовой серверной |

Как видно из рисунка, такая типовая серверная поддерживает энергопотребление до 400 Вт, если температура в ней не должна превышать 25°C, и 1000 Вт, если приемлемым уровнем считается значение 32°C.

Впрочем, серверные отличаются своими размерами и использованными стройматериалами, а на соотношение между температурой и энергопотреблением влияют и другие факторы, которые ограничивают использование этого метода. Основные факторы и характер их влияния перечислены в табл. 2.

| Таблица 2. Факторы, оказывающие влияние на температуру в серверной, и ожидаемый результат их воздействия |

Наиболее очевидный фактор — размеры помещения. Чем больше комната, тем лучше рассеивается тепло благодаря большей площади стен, потолка и пола. И чем она меньше, тем ниже эффективность охлаждения за счет естественной теплопроводности. Разница в эффективности представлена на рис. 3.

| Рис. 3. Влияние размеров помещения на эффективность охлаждения за счет естественной теплопроводности |

Материалы, используемые при строительстве стен, потолка и пола, тоже оказывают влияние на соотношение между температурой и рабочей нагрузкой, поскольку способность пропускать тепло у разных материалов разная. Если мы заменим стены из гипсокартона и панельный подвесной потолок, приведенные в примере выше, на 10-сантиметровые бетонные стены и 10-сантиметровые железобетонные перекрытия, эффективность охлаждения заметно повысится. Это наглядно можно увидеть на рис. 4.

Если мы заменим стены из гипсокартона и панельный подвесной потолок, приведенные в примере выше, на 10-сантиметровые бетонные стены и 10-сантиметровые железобетонные перекрытия, эффективность охлаждения заметно повысится. Это наглядно можно увидеть на рис. 4.

| Рис. 4. Влияние строительных материалов на эффективность охлаждения за счет естественной теплопроводности |

Зачастую эффективность охлаждения за счет естественной теплопроводности снижается из-за повышения температуры внутри здания после отключения систем кондиционирования на выходные. Когда такое происходит, температура в серверной с ИТ-оборудованием синхронно увеличивается. В нашем примере при увеличении в выходные дни температуры внутри здания с 20 до 29°C (то есть на 9°C) можно ожидать соответствующего увеличения на 9°C и внутри серверной. Это означает, что в критичной серверной, где температура не должна превышать 25°C, придется отключить всю нагрузку, а в некритичной, где можно допустить 32°C, уровень энергопотребления не должен быть выше 250 Вт.

Еще одно ограничение такого метода охлаждения связано с тем, что, если стены помещения одновременно являются внешними стенами здания, температура внутри будет зависеть от температуры внешней стены, на которую влияют как состояние окружающей среды, так и нагрев под воздействием солнца. Поэтому помещение, примыкающее к наружным стенам, в солнечные дни может перегреваться. В нашем примере в комнате размером 3 × 3 × 3 м при температуре 38°C на улице и солнечной теплоотдаче 1000 Вт/м2 можно ожидать повышения температуры внутри помещения на 4–7°C.

Эффективность охлаждения за счет естественной теплопроводности в закрытых помещениях варьируется в зависимости от их размеров, конструкционных материалов и внешних условий. В общем случае охлаждения исключительно за счет теплопроводности в критичных залах оказывается достаточно, если общее энергопотребление внутри помещения не превышает 400 Вт. При этом следует учитывать влияние и других факторов, перечисленных выше. В некритичных помещениях такой тип охлаждения можно использовать, если энергопотребление оборудования не превышает 1000 Вт.

Итак, этот метод пригоден только при использовании маломощных ИТ-устройств, например стековых сетевых коммутаторов. Как видно из приведенных выше примеров, при увеличении энергопотребления температура быстро увеличивается. Учтите, что тепло выделяют и другие потребители энергии, в частности электрические лампочки. Поэтому освещение зала нужно организовать с использованием экономичных источников, которые автоматически отключались бы, когда в помещении никого нет.

ПАССИВНАЯ И ПРИНУДИТЕЛЬНАЯ ВЕНТИЛЯЦИЯ: ТЕПЛО ОТВОДИТСЯ В БОЛЕЕ ХОЛОДНУЮ СРЕДУ ЧЕРЕЗ ВЕНТИЛЯЦИОННЫЕ ОТВЕРСТИЯ И РЕШЕТКИ

Залы можно охлаждать с помощью воздуха, поступающего из остальной части здания. При этом применяется как пассивная вентиляция через специальные отверстия и воздухозаборники, так и активная — с помощью вентиляторов. Основное условие заключается в том, чтобы температура в зале не превышала значительно температуру в здании.

Примеры систем вентиляции представлены на рис. 5. Как показано на рис. 6, температура в вентилируемом помещении меняется в соответствии с уровнем энергопотребления ИТ-оборудования.

Как показано на рис. 6, температура в вентилируемом помещении меняется в соответствии с уровнем энергопотребления ИТ-оборудования.

| Рис. 5. Примеры двух типов вентиляции помещений: а — пассивная вентиляция; б — принудительная вентиляция |

В графическом виде эта ситуация представлена на рис. 5. Кривая пассивной вентиляции характеризует работу оборудования, изображенного на рис. 5, а. В случае принудительной вентиляции (рис. 5, б) температура повышается медленнее (по сравнению с пассивной), при этом предполагается, что поток воздуха генерируется со скоростью 226,5 л в секунду. Рост температуры снижается по мере увеличения потока воздуха. Для этого необходимо установить вентиляторы большей мощности или дополнительную вентиляционную систему.

| Рис. 6. Зависимость температуры в помещении от энергопотребления ИТ-оборудования при пассивной и принудительной вентиляции |

Вентиляция — очень практичный метод охлаждения зала. Для критичных помещений при энергопотреблении ниже 700 Вт вполне достаточно пассивной вентиляции, а если энергопотребление составляет от 700 до 2000 Вт, справится принудительная. Поддержка еще более высоких уровней энергопотребления достигается путем увеличения мощности вентиляторов или установки дополнительных вентиляционных систем.

Для критичных помещений при энергопотреблении ниже 700 Вт вполне достаточно пассивной вентиляции, а если энергопотребление составляет от 700 до 2000 Вт, справится принудительная. Поддержка еще более высоких уровней энергопотребления достигается путем увеличения мощности вентиляторов или установки дополнительных вентиляционных систем.

В некритичных помещениях для энергопотребления, не превышающего 1750 Вт, достаточно пассивной вентиляции, а в случае 1750–4500 Вт — принудительной. Правильное размещение вентиляционных отверстий и вентиляторов по отношению к ИТ-оборудованию тоже способствует эффективному охлаждению. При этом методе важное значение имеют внешние факторы, роль которых была проиллюстрирована на рис. 4 и 5.

КЛИМАТ-КОНТРОЛЬ: ТЕПЛО МОЖНО ОТВОДИТЬ С ПОМОЩЬЮ ОХЛАЖДАЮЩИХ СИСТЕМ ЗДАНИЯ

Во многих зданиях уже установлены системы кондиционирования воздуха или объединенные системы кондиционирования и обогрева, позволяющие создать комфортные условия для персонала. Обычно у таких решений имеется система каналов и воздуховодов, которой можно воспользоваться при прокладке дополнительных вентиляционных каналов. Однако с помощью простого добавления последних редко удается решить проблему охлаждения залов, зачастую, напротив, ситуация только усугубляется.

Обычно у таких решений имеется система каналов и воздуховодов, которой можно воспользоваться при прокладке дополнительных вентиляционных каналов. Однако с помощью простого добавления последних редко удается решить проблему охлаждения залов, зачастую, напротив, ситуация только усугубляется.

Системы комфортного кондиционирования периодически включаются и отключаются. В качестве стандартного средства контроля обычно используется термостат, который размещается в заданной зоне, но не в серверной. Для небольшого пространства серверной, в которой находятся ИТ-устройства, это означает, что температура будет то снижаться, то возрастать. Однако ее существенные перепады наносят еще больший вред оборудованию.

Передовой опыт использования систем комфортного кондиционирования предусматривает ослабление заданных настроек температуры по ночам и в выходные с целью экономии электроэнергии. Некоторые системы вообще отключаются. Если серверная является частью более крупной зоны, средняя температура в ней увеличивается в соответствии с заданным ограничением. При добавлении канала придется сделать выбор между напрасным расходом электроэнергии по ночам и выходным и еще большим увеличением температурных скачков в серверной.

При добавлении канала придется сделать выбор между напрасным расходом электроэнергии по ночам и выходным и еще большим увеличением температурных скачков в серверной.

Чтобы использовать систему комфортного кондиционирования для охлаждения серверной, ее нужно превратить в выделенную зону с собственными прямыми и возвратными каналами, воздухораспределительными устройствами (вентиляторным доводчиком, системой кондиционирования с переменным расходом воздуха) и управляющими устройствами (термостатами). Но такое решение непрактично.

Организация выделенной зоны для серверной сопряжена со следующими трудностями:

- Обеспечение адекватного постоянного статического давления во входном канале системы кондиционирования с переменным расходом воздуха (Variable Air Volume, VAV), особенно в жаркие летние дни, когда охлаждающее оборудование работает на полную мощность.

- Очень низкая плотность рассеиваемой мощности. Большинство систем комфортного охлаждения должны обеспечивать охлаждение на уровне 43–54 Вт/м2, что эквивалентно 150 Вт на стойку (если считать, что каждая стойка занимает 2,8 м2).

- Недостаточная масштабируемость.

- Высокая стоимость реализации.

Зачастую центральная система охлаждения является частью основной или дополнительной системы отопления. В таких ситуациях входной воздуховод, построенный для охлаждения серверной, в зимние месяцы будет подавать туда тепло. А это всегда нежелательно.

Вмешательство в систему комфортного кондиционирования здания для охлаждения ИТ-помещений в общем случае недопустимо. Если воздуховод уже существует, его нужно убрать или отключить либо заменить или дополнить одним из других ранее уже описанных подходов.

СПЕЦИАЛЬНОЕ ОХЛАЖДЕНИЕ: ТЕПЛО МОЖЕТ ОТВОДИТЬСЯ ВЫДЕЛЕННЫМ КОНДИЦИОНЕРОМ ВОЗДУХА

Наиболее эффективный способ обеспечить контроль за температурой в серверной — это установка выделенного оборудования для кондиционирования помещения. Однако, по сравнению с использованием пассивной или принудительной вентиляции, выделенное кондиционирование может оказаться слишком сложным и дорогостоящим решением. Такой вариант следует выбирать, только когда это действительно требуется.

Такой вариант следует выбирать, только когда это действительно требуется.

В общем случае выделенную систему кондиционирования рекомендуется устанавливать, когда уровень мощности превышает примерно 2000 Вт для критичных серверных помещений и 4500 Вт для некритичных. При определении мощности очень важно учитывать подробные спецификации энергопотребления, предоставленные поставщиком ИТ-оборудования, и установить уровень мощности для конкретной конфигурации ИТ-оборудования.

Как правило, фактическая мощность конкретного оборудования значительно ниже номинальной, которая указывается на задней панели, и ее правильное определение может избавить от существенных затрат и уменьшить сложность системы охлаждения. К примеру, конфигурируемые маршрутизаторы с номинальной мощностью 5–6 кВт на самом деле потребляют всего 1–2 кВт. При правильных расчетах, возможно, кондиционер и не понадобится.

Бывают ситуации, когда выделенный кондиционер нужен, даже если вентиляция представляется технически жизнеспособной альтернативой. К таковым относятся:

К таковым относятся:

- наличие в вентиляционном воздухе за пределами серверной значительной доли пыли и других загрязняющих веществ;

- подверженность вентиляционного воздуха за пределами серверной существенным перепадам температуры;

- невозможность добавления вентиляционных воздуховодов в связи с особенностями условий аренды или ремонта.

В таких случаях вентиляция, в которой используется воздух, находящийся внутри здания, оказывается нежизнеспособной альтернативой и остается единственный вариант — монтаж выделенной системы кондиционирования.

ВЛИЯНИЕ ИБП НА СИСТЕМУ ОХЛАЖДЕНИЯ СЕРВЕРНОЙ

Общая и рекомендованная практика заключается в использовании в серверных небольших распределенных систем ИБП для обеспечения непрерывности бизнеса. В зависимости от предъявляемых требований они могут предоставлять резервное питание ИТ-нагрузки в течение короткого или увеличенного (больше часа) периода времени. В любом случае тепловая нагрузка, создаваемая ИБП, значительно ниже соответствующей нагрузки ИТ-оборудования, и ее можно проигнорировать.

При наличии ИБП ИТ-оборудование по-прежнему будет в течение какого-то времени генерировать тепло в случае прекращения энергоснабжения. Поэтому охлаждающая система не должна отключаться. Если продолжительность расчетной работы от ИБП меньше 10 мин, термальная масса воздуха и поверхности стен внутри серверной сохраняют температуру в разумных пределах. Никаких предварительных мер предпринимать не требуется.

Если же ИБП спроектированы для поддержки нагрузки на протяжении более чем 10 мин, системы охлаждения должны работать в течение всего этого периода. Это означает, что при использовании системы принудительной вентиляции или воздушного кондиционера вентилятор и кондиционер должны получать энергоснабжение от ИБП. Потребность в энергоснабжении вентилятора или кондиционера нужно учитывать при расчете необходимой мощности ИБП.

В случае принудительной вентиляции эта проблема стоит не так остро, но для кондиционеров нужны значительно более мощный ИБП и более емкие батареи (зачастую пусковой ток кондиционера в 4–6 раз превышает номинальный). Поэтому при наличии возможности следует использовать не кондиционеры, а принудительную вентиляцию.

Поэтому при наличии возможности следует использовать не кондиционеры, а принудительную вентиляцию.

Практичной и экономичной альтернативой кондиционеру, выделенному для ИБП, считается установка принудительной вентиляции. В идеале вентиляционная система должна получать энергоснабжение при любых условиях, чтобы обеспечивать определенный уровень воздухообмена в комнате. При этом выделенный кондиционер не задействован. Система принудительной вентиляции выполняет резервную роль до момента восстановления энергоснабжения (и автоматического повторного запуска кондиционера).

АТРИБУТЫ ЭФФЕКТИВНОЙ ПРИНУДИТЕЛЬНОЙ ВЕНТИЛЯЦИИ

На основании вышеизложенного можно сделать вывод, что чрезмерное тепло в серверной должно вызывать обоснованное беспокойство, а самыми простыми решениями в данном случае являются пассивная или принудительная вентиляция. Несмотря на то что пользователям доступен большой выбор таких систем, существуют и готовые решения с хорошими характеристиками, предназначенные специально для охлаждения серверных. В табл. 3 указано, на что следует обратить внимание при создании вентиляционной системы для серверной.

В табл. 3 указано, на что следует обратить внимание при создании вентиляционной системы для серверной.

| Таблица 3. Функции и преимущества вентиляционной системы |

ЗАКЛЮЧЕНИЕ

Для большинства ИТ-помещений наиболее эффективной и практичной стратегией охлаждения является вентиляция. Хорошо спроектированная и реализованная система пассивной вентиляции эффективна при низких уровнях нагрузки. Для серверных, где установлены маршрутизаторы VoIP и серверы с высоким уровнем энергопотребления, рекомендуется спроектировать принудительную вентиляцию.

Когда уровень энергопотребления в критичных серверных превышает 2000 Вт (4500 Вт в некритичных серверных) либо окружающий воздух за их пределами становится горячим, неконтролируемым или загрязненным, предпочтительна установка выделенного кондиционера воздуха. Использовать существующие системы комфортного кондиционирования для охлаждения серверной нежелательно, поскольку почти всегда возможны колебания температуры внутри помещения.

Появление вентиляционных систем, специально разработанных для ИТ-помещений, упрощает процесс выбора и позволяет внедрять стандартизированные решения для их охлаждения.

Нил Расмуссен, старший президент по инновациям в Schneider Electric,

Брайан Стэндли, менеджер линейки малых систем охлаждения в American Power Conversion

Стратегии охлаждения для серверных и небольших помещений

Поделитесь материалом с коллегами и друзьями

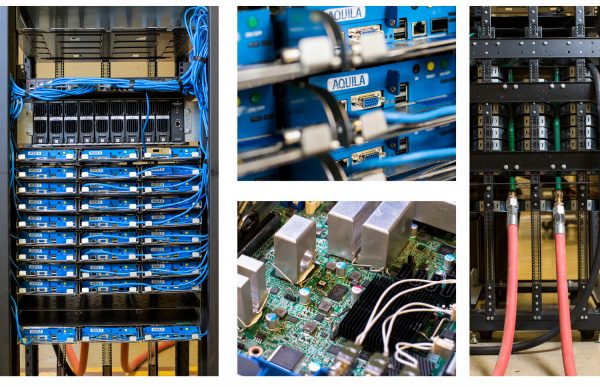

Охлаждение серверной | АквилонСтройМонтаж

Охлаждение серверной – помещения, в котором размещаются компьютеры, сервера, очень важно для полноценной работы предприятия. Это важнейшие технические объекты, несущие всю информационную базу и обеспечивающие связь компании с внешним миром. При работе оборудование выделяет тепло. Если не избавляться от него, то это пагубно скажется на функционировании электроники. При этом нужно добиться не только охлаждения серверной комнаты, но и соблюсти ряд других параметров – поддерживать на определенном уровне влажность и устранять запыленность. В противном случае дорогостоящая электронная техника быстро выйдет из строя. Именно поэтому грамотно спроектированные системы кондиционирования – первостепенная задача при обустройстве серверного помещения.

Если не избавляться от него, то это пагубно скажется на функционировании электроники. При этом нужно добиться не только охлаждения серверной комнаты, но и соблюсти ряд других параметров – поддерживать на определенном уровне влажность и устранять запыленность. В противном случае дорогостоящая электронная техника быстро выйдет из строя. Именно поэтому грамотно спроектированные системы кондиционирования – первостепенная задача при обустройстве серверного помещения.

Нажмите на картинку, чтобы увеличить ее.

Система охлаждения сервернойСуществует несколько разных систем, обеспечивающих охлаждение серверных помещений. Однако не все климатические системы одинаково эффективно справляются с поставленными задачами. Давайте рассмотрим самые распространенные методы кондиционирования и постараемся найти оптимальное решение.

5 причин приобрести системы охлаждения помещений от АквилонСтройМонтаж

- Использовании технологии Регулируемой газовой среды

- Поддержание заданного температурного режима в каждой точке объема помещения

- Точное распределение воздушного потока при заданной температуре.

- Подбор оборудования исходя из существующей теплоизоляции

- Комплексное использование охлаждения и вентиляции

ОСТАВИТЬ ЗАЯВКУ

Сплит-система

1.Сплит-система подойдет для небольших помещений с умеренным количеством компьютерной техники. Это могут быть бытовые или промышленные сплит-системы повышенной мощности. Используются разные типы – канальные, настенные, колонные, реже – потолочные. Желательно, еще на стадии проектирования предусмотреть дублирующую климатическую систему на случай поломки основной. Дополнительно приходится монтировать зимний комплект и другие опции для исключения вероятности поломки. Отсюда можно сделать вывод, что охлаждение в серверной при помощи сплит систем имеет немало недостатков:

- Температура поддерживается с недостаточной точностью.

- Воздух чрезмерно иссушается, что приводит к лишней наэлектризованности.

- Неэффективная система фильтрации и малая мощность вентиляторов приводят к появлению пыли, губительной для серверов.

- Конденсация выделяемой влаги сопровождается лишним расходом энергии, поэтому КПД понижается.

- Круглосуточная и круглогодичная эксплуатация системы очень быстро приводит к выработке ресурса.

Прецизионные кондиционеры

Прецизионные кондиционеры стоят дороже, но гораздо надежнее, если нужно охлаждение для серверной. Это профессиональные климатические системы, способные точно поддерживать заданную температуру и создавать необходимый уровень влажности. По сравнению со сплит-системами они обладают рядом неоспоримых достоинств:

- Точнейший температурный режим и уровень влажности.

- Могут работать круглогодично без перебоев.

- Спокойно выдерживают эксплуатацию при сильном морозе и жаре. Некоторые из них выдерживают показатели от -60 до +60С.

- Совместимы с системами управления и диспетчерского контроля.

Классификация этих систем обширна. Они могут выполняться по типу моноблоков или сплит-систем, но при этом имеют совсем другие характеристики. Стандартная система состоит из каркаса с автоматикой, фильтрами, теплообменниками, вентиляторами, силовой электрикой и элементами холодильного контура. Панели надежно защищают все содержимое от негативных внешних воздействий. Их принцип работы достаточно прост. Прибор забирает воздух из помещения или снаружи, внутри он охлаждается, увлажняется и выпускается в помещение. Забор воздуха осуществляется разными способами – снизу или сверху.

Стандартная система состоит из каркаса с автоматикой, фильтрами, теплообменниками, вентиляторами, силовой электрикой и элементами холодильного контура. Панели надежно защищают все содержимое от негативных внешних воздействий. Их принцип работы достаточно прост. Прибор забирает воздух из помещения или снаружи, внутри он охлаждается, увлажняется и выпускается в помещение. Забор воздуха осуществляется разными способами – снизу или сверху.

Исходя из площади серверной, можно рассматривать три варианта систем охлаждения:

- Охлаждается вся площадь в целом.

- Обслуживается каждый ряд серверов по отдельности.

- Индивидуальное обслуживание каждой стойки и серверного шкафа.

Чаще всего отдают предпочтение первому способу, так как он достаточно эффективен и при этом прост в выполнении. Но стоит отметить неравномерное расхождение охлажденного воздуха, поэтому его целесообразно использовать только для небольших помещений. Кондиционирование по рядам считается более рациональным. На каждый ряд устанавливается отдельный блок, отвечающий за охлаждение.

На каждый ряд устанавливается отдельный блок, отвечающий за охлаждение.

Если вас интересует охлаждение серверной, но вы не знаете, какому способу отдать предпочтение, то просто обратитесь к нашим специалистам. Квалифицированная помощь быстро решит ваши проблемы. Компания «АквилонСтройМонтаж» по вашему запросу займется разработкой индивидуальной системы в зависимости от площади помещения, количества и технических характеристик установленного в нем оборудования. У нас вы можете рассчитывать на умеренные цены, высокое качество оборудования и предоставляемых услуг.

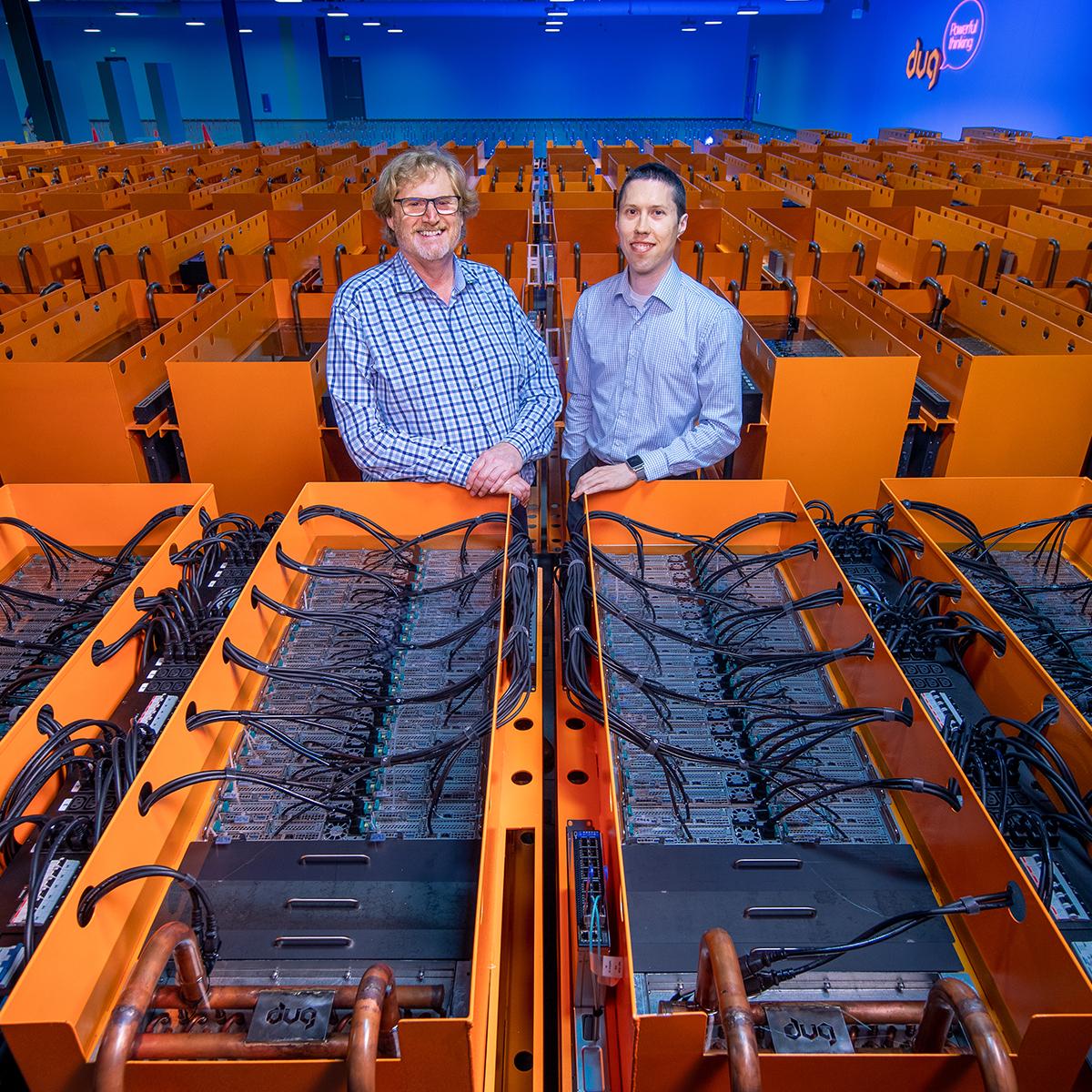

Охлаждение серверов: новости от Microsoft, Google, Wiwynn, Cooler Master, Vert Rotors, Asperitas и Shell

До недавнего времени мощность IT-оборудования внутри серверных стоек ЦОД оставалась стабильной на уровне от 3 до 5 кВт, что позволяло оптимизировать температурный режим серверов с помощью воздушного охлаждения, используя чиллеры и кондиционеры для машзалов.

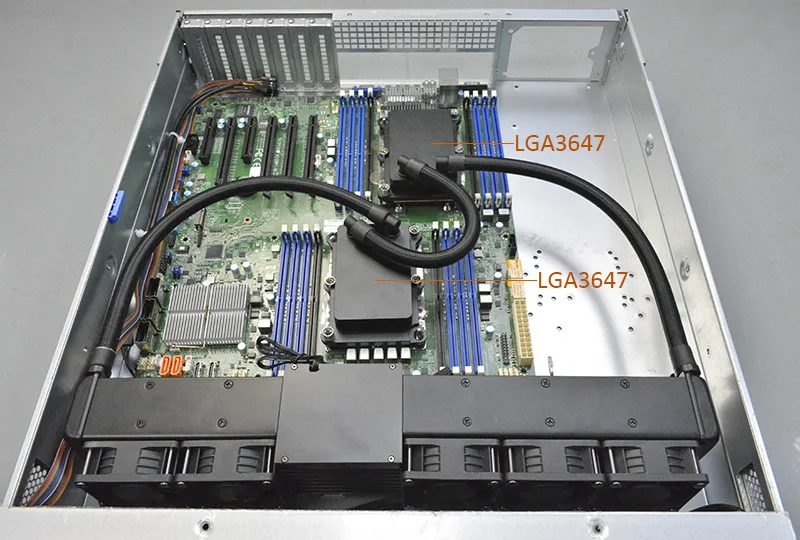

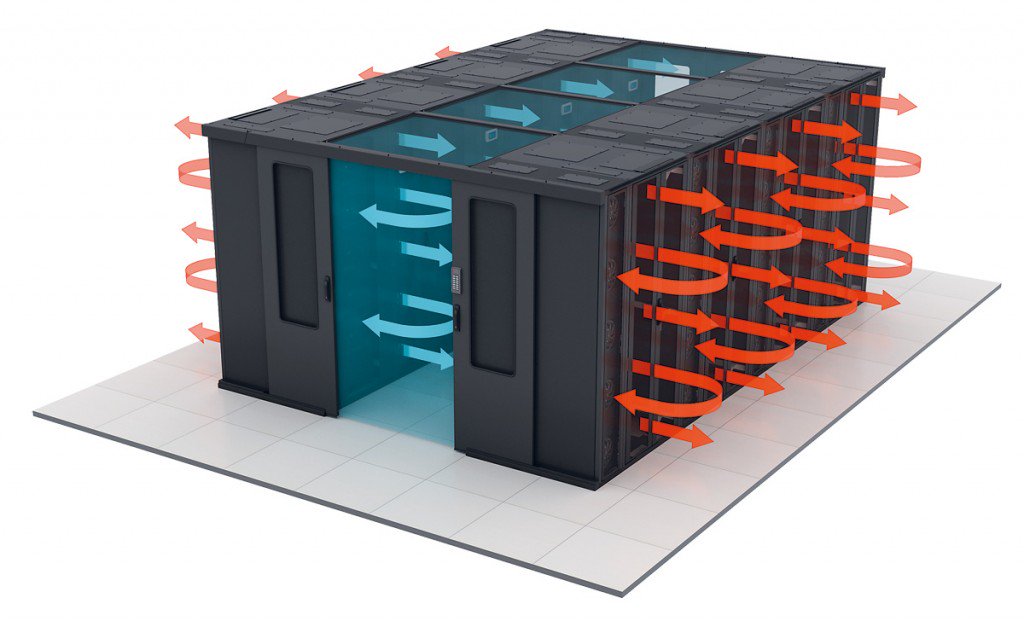

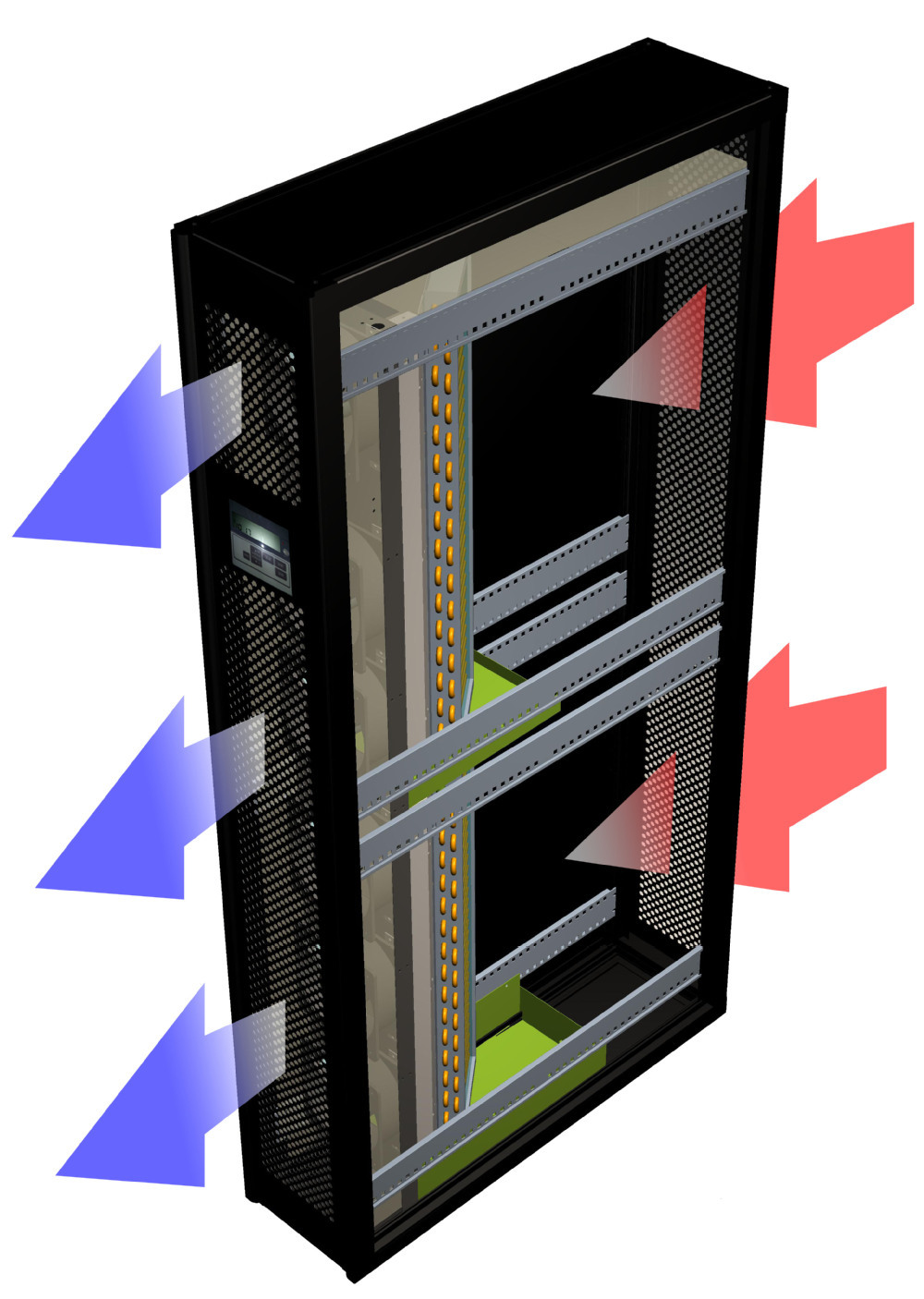

Когда плотность мощности IT-оборудования внутри среднестатистической стойки увеличилась до 10 кВт, встал вопрос о повышении эффективности воздушного охлаждения. Для этого были созданы системы «горячих» и «холодных» коридоров, обеспечивая значительную экономию энергии через предотвращение смешивания холодного воздуха, поступающего к серверу, и нагретого воздуха, выходящего из сервера, с помощью физического барьера.

Для этого были созданы системы «горячих» и «холодных» коридоров, обеспечивая значительную экономию энергии через предотвращение смешивания холодного воздуха, поступающего к серверу, и нагретого воздуха, выходящего из сервера, с помощью физического барьера.

Но на фоне продолжающегося роста плотности мощности IT-оборудования внутри серверных стоек операторы, строители и проектировщики ЦОД вынуждены искать еще более продвинутые подходы к оптимизации температурного режима серверов. И помогают им в этом такие вендоры как Microsoft, Google, Wiwynn, Cooler Master, Vert Rotors, Asperitas и Shell.

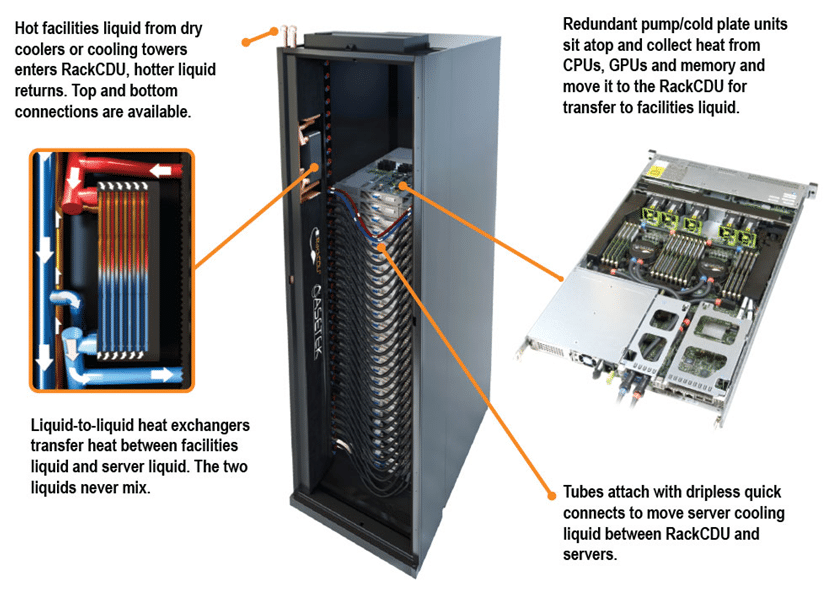

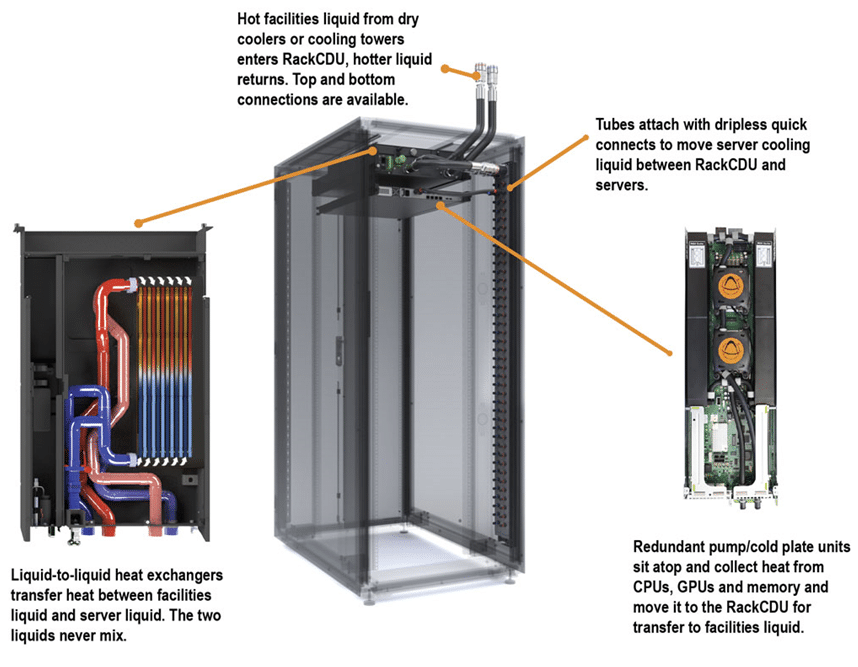

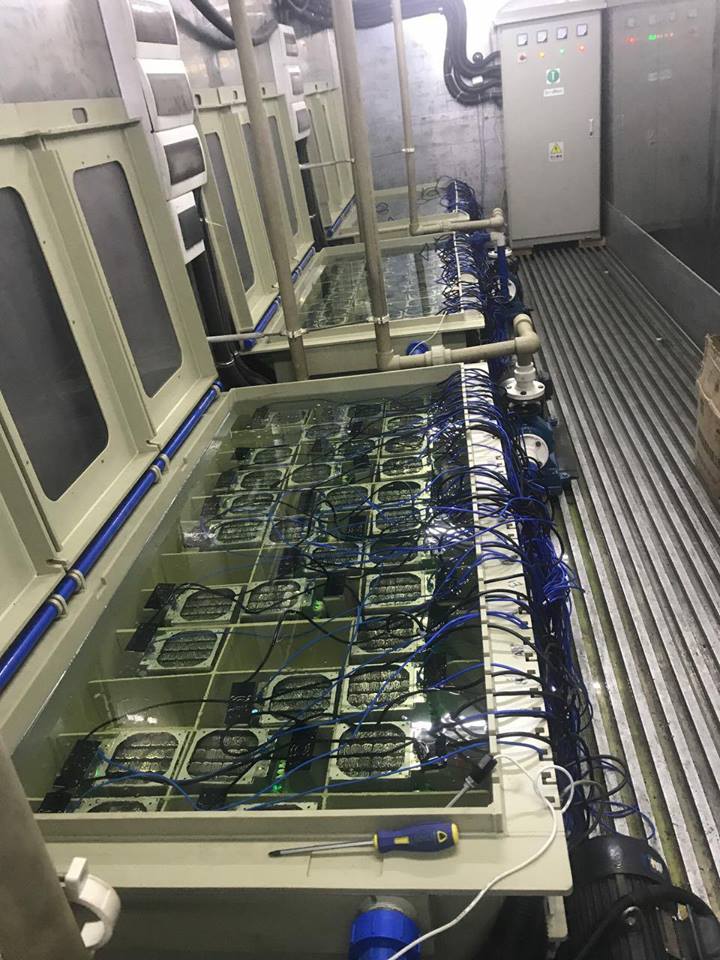

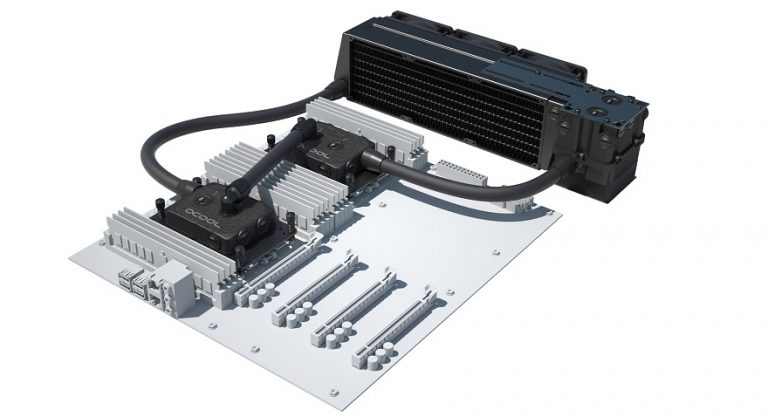

Автономное решение для жидкостного охлаждения на уровне стойки от Wiwynn

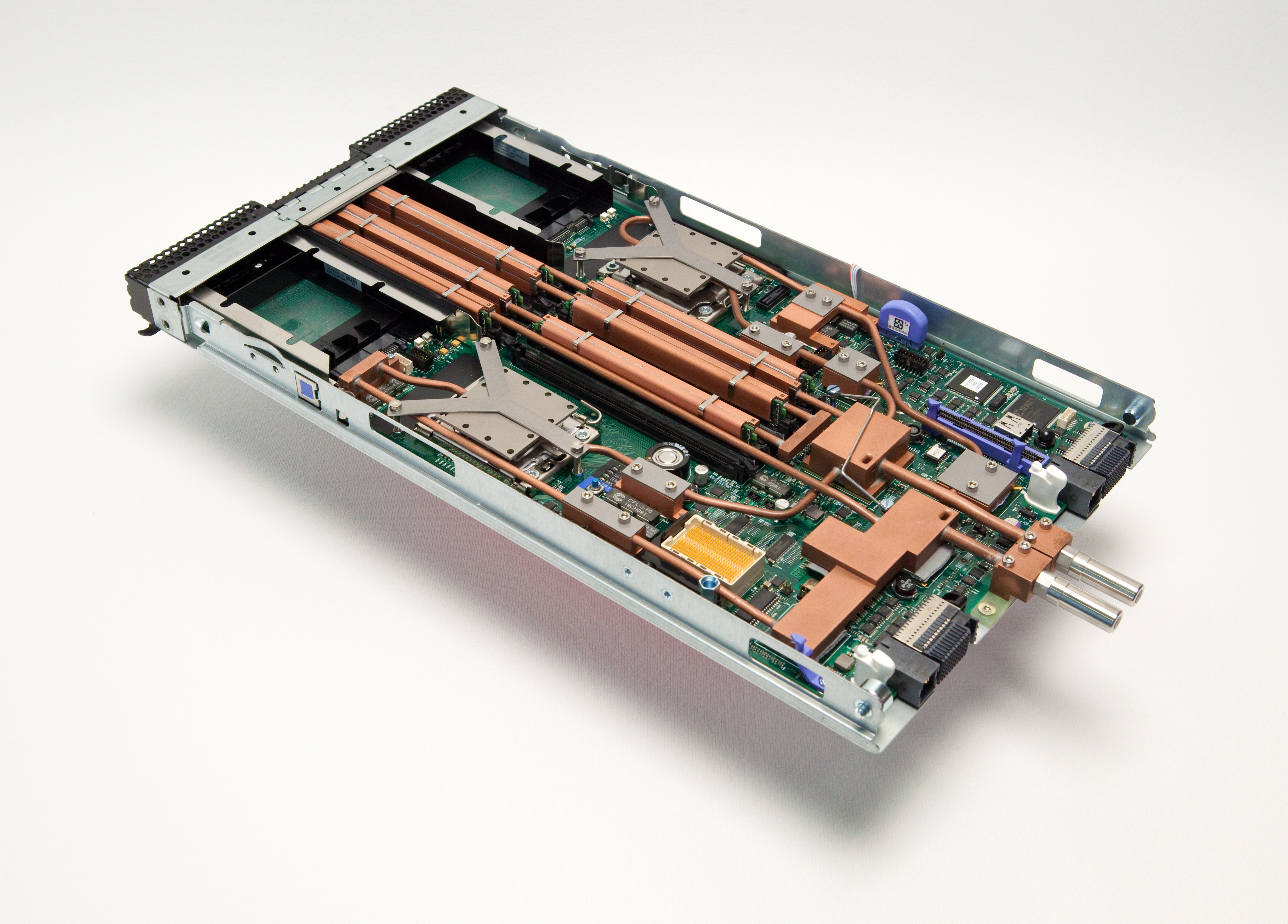

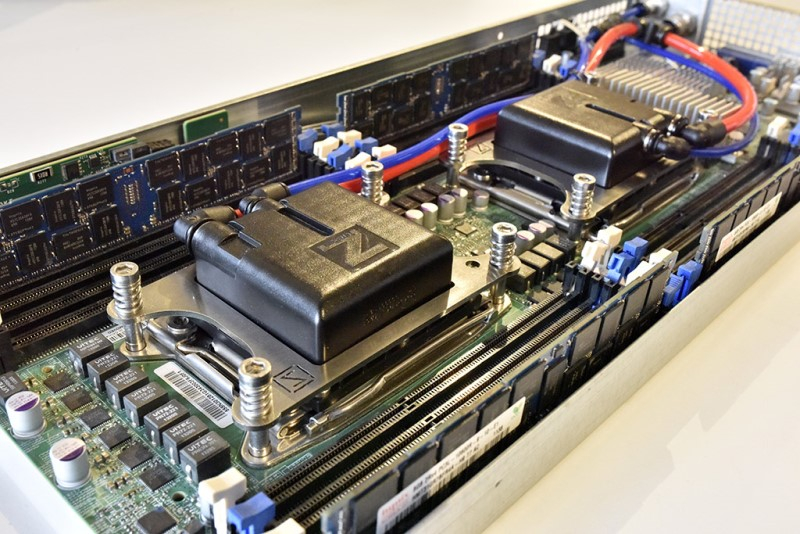

Компания Wiwynn продемонстрировала автономное решение для жидкостного охлаждения на уровне стойки с серверами следующего поколения, совместимое с открытыми спецификациями Open Compute Project (OCP). Решение поддерживает спецификацию Open Rack Standard V3 (ORV3) от Open Compute Project и обратно совместимо с OCP ORV2.

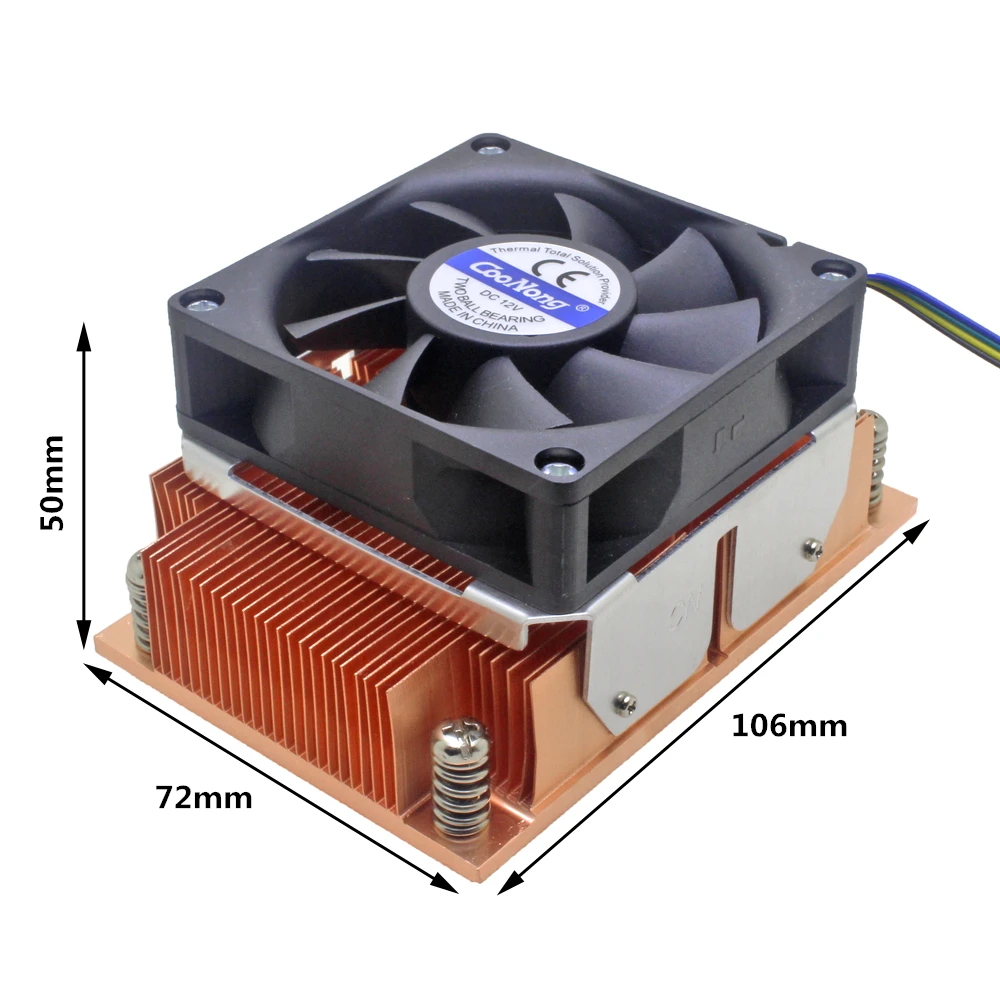

Усовершенствованное решение Wiwynn для жидкостного охлаждения серверов поддерживает плотность мощности на уровне до 36 кВт на стойку. Система использует теплообменник на задней дверце стойки (RDHx) для охлаждения жидкости, которая передает тепло от мощных компонентов серверов (CPU, GPU или ASIC) через охлаждающие пластины.

Такая конструкция делает продукт автономным, не требует дополнительных охлаждающих блоков и внесения изменений в уже развернутую инфраструктуру ЦОД. А поддержка быстроразъемных соединений повышает удобство обслуживания и управления.

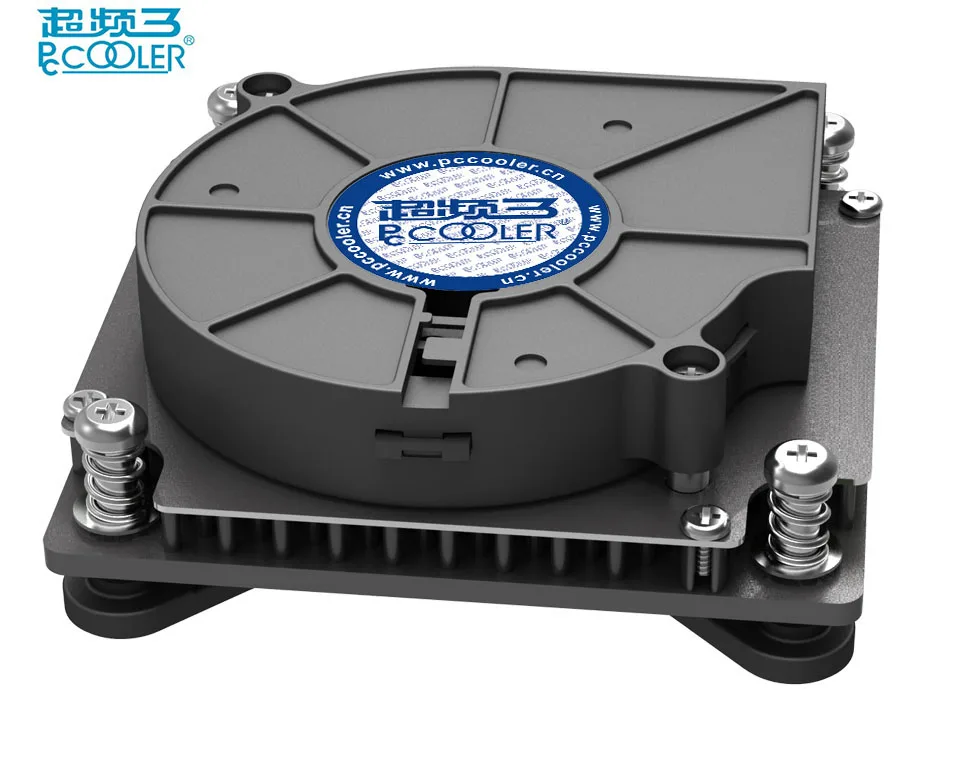

Hyve Solutions и Cooler Master будут вместе создавать серверы с системами жидкостного охлаждения

Ведущий поставщик серверов для гипермасштабных дата-центров Hyve Solutions Corporation объявил о заключении соглашения о партнерстве с компанией Cooler Master Corporation, которая является крупным производителем охладительных решений. Вендоры будут совместно проектировать и производить передовые серверы на базе новейших технологий жидкостного охлаждения для высокоплотных гипермасштабных вычислительных систем.

В частности, партнеры обещают, что их продукты позволят операторам ЦОД удвоить вычислительную мощность без повышения занимаемой теплообменниками площади относительно аналогов на базе воздушного охлаждения. Вендоры нацелены главным образом на сегмент компактных высокопроизводительных вычислительных систем.

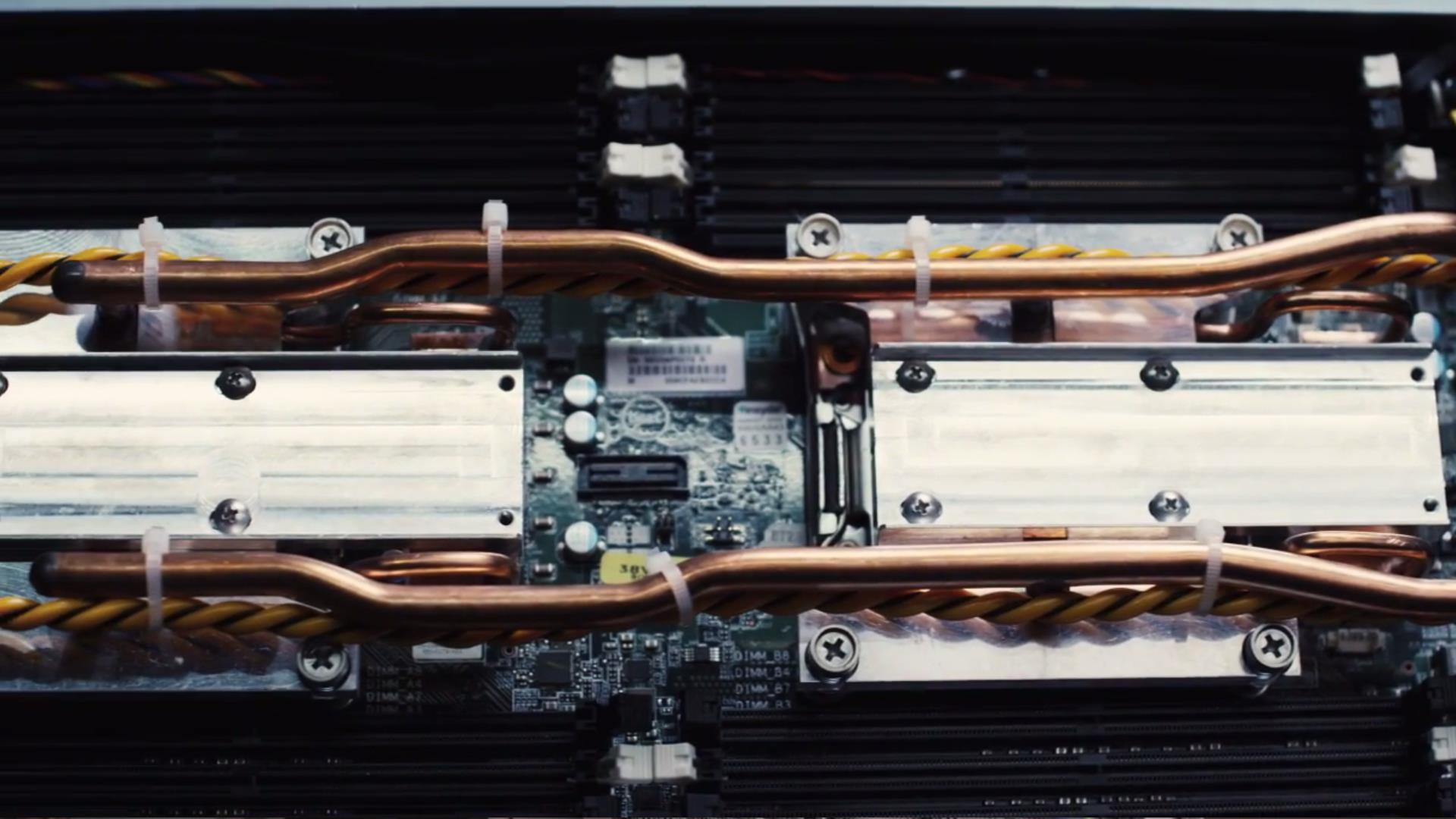

Microsoft делится технологиями жидкостного охлаждения серверов

Софтверный гигант Microsoft опубликовал в открытом доступе в рамках инициативы Open Compute Project ряд спецификаций на технологии и системы охлаждения центра обработки данных. Об этом было объявлено на саммите OCP, который в этом году был переведен через интернет из-за пандемии Covid-19.

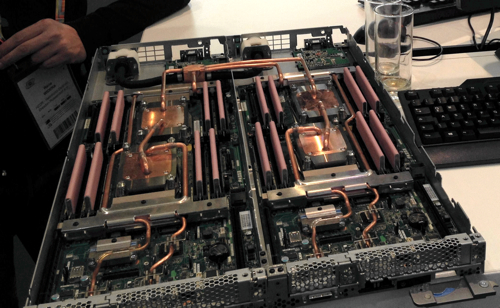

Представители Microsoft также заявили, что корпорация работает с некоторыми членами OCP, включая Facebook и CoolIT, над созданием нового стандарта по разработке систем оптимизации температурного режима серверов на базе на базе охлаждающих пластин. Такие устройства использовались в суперкомпьютерах в течение многих лет. Но в текущем виде они очень индивидуализированы и не предназначены для легкого обслуживания.

Но в текущем виде они очень индивидуализированы и не предназначены для легкого обслуживания.

Эксперты софтверного гиганта предсказывают, что жидкостное охлаждение в целом и, в частности, охлаждение серверов погружением выйдут на передний план и продлят существование закона Мура, предполагающего регулярное удвоение плотности размещения транзисторов и вычислительной мощности каждые полтора-два года.

Vert Rotors создает роторный компрессор нового типа

Эдинбургская компания Vert Rotors получила финансирование в размере 720 000 фунтов стерлингов для усовершенствования роторного компрессора новой конструкции и организации массового производства этого продукта. Компания стоит за разработкой конического роторного компрессора, который, как говорят ее инженеры, способен создавать высокое давление при переменных скоростях работы с низким уровнем шума и вибрации.

Вместо того чтобы вращать роторы, расположенные рядом друг с другом, технология Vert Rotors предполагает размещение одного ротора внутри другого. Роторы вращаются в одном и том же направлении с разными скоростями, сжимая воздух по мере его движения вниз по конусу. Это приводит к значительному росту эффективности без увеличения занимаемого пространства и веса.

Роторы вращаются в одном и том же направлении с разными скоростями, сжимая воздух по мере его движения вниз по конусу. Это приводит к значительному росту эффективности без увеличения занимаемого пространства и веса.

Технология Vert Rotors была разработана для различных форм-факторов, а также для реализации индивидуальных проектов, требующих сжатия воздуха, газа или хладагентов, Два воздушных компрессора с использованием этой технологии были представлены в прошлом году.

Дополнительное финансирование от группы существующих инвесторов, включая Par Equity, Equity Gap, Aero Den и Scottish Investment Bank, позволит компании организовать массовое производство продукции и вывести ее на новые рынки.

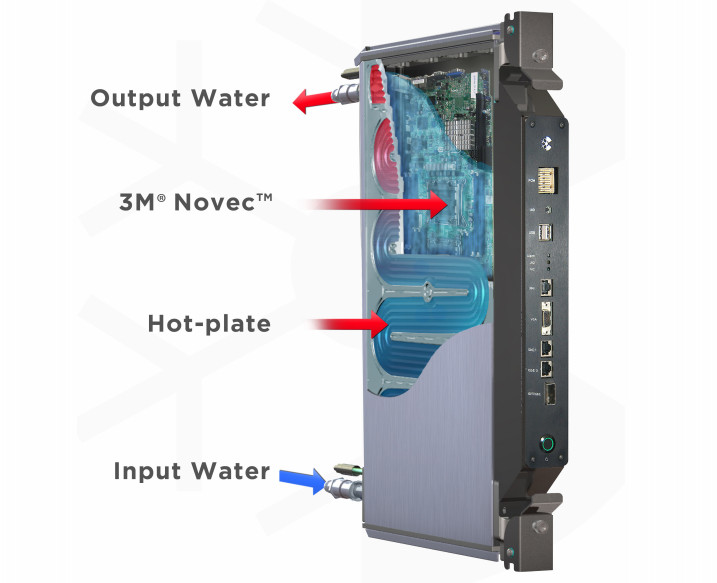

Asperitas и Shell анонсировали новую охлаждающую платформу и жидкость для иммерсионного охлаждения серверов

Новая платформа охлаждения и охлаждающая жидкость были совместно анонсированы Asperitas и Shell на виртуальной конференции Open Compute Project. Новая жидкость Shell Immersion Cooling Fluid S5 X была представлена вместе с новым устройством для жидкостного охлаждения Asperitas AIC24 21.

Хладагент, разработанный Shell в сотрудничестве с Asperitas, представляет собой синтетическую однофазную жидкость для иммерсионного охлаждения, изготовленную из газа с использованием технологии газожидкостной конверсии Shell. Эта охлаждающая жидкость предназначена для снижения энергетических затрат и выбросов благодаря своим термодинамическим свойствам. Она будет доступна на рынке систем иммерсионного охлаждения серверов.

Что касается нового продукта Asperitas, речь о крупном резервуаре для иммерсионного охлаждения серверов. Он может вместить 24 сервера шириной в 21 дюйм каждый. Продукт позиционируется как решение для иммерсионного охлаждения с естественной конвекцией, но в заявлении компании также говорится, что применяемая в Asperitas AIC24 21 охлаждающая жидкость может использоваться в системах с помпой / принудительной циркуляции хладагента от других поставщиков.

Новый продукт может использоваться для рекуперации тепла. При этом более 98 процентов выделяемой серверами тепловой энергии превращается в горячую воду. Каждый блок Asperitas AIC24 21 поставляется в комплекте с интеллектуальной системой мониторинга и управления на основе встроенных датчиков.

Каждый блок Asperitas AIC24 21 поставляется в комплекте с интеллектуальной системой мониторинга и управления на основе встроенных датчиков.

Google AlphaGo поможет снизить энергозатраты на охлаждение серверов

Поисковый гигант Google в сотрудничестве с британской компанией по искусственному интеллекту (ИИ) DeepMind ведет разработку алгоритма ИИ, который снижает энергопотребление ЦОД за счет повышение эффективности систем охлаждения серверов, не требуя развертывания нового дорогостоящего оборудования.

Алгоритм Google и DeepMind, получивший название AlphaGo в связи с его способностью побеждать людей в настольную игру Go, ранее уже был применен в центрах обработки данных Google, что привело к снижению затрат на системы охлаждения на 40 процентов. Этот алгоритм методом проб и ошибок определяет лучшую конфигурацию инфраструктуры охлаждения.

Используя методы глубокого обучения, ИИ разбивает огромное количество статистических данных в разрезе различных аспектов работы центра обработки данных и использует прогнозное моделирование для оценки влияния на энергопотребление тех или иных факторов.

Система глубокого обучения помогает установить вероятные взаимосвязи между различным холодильным оборудованием и IT-инфраструктурой и, применяя прогностические модели, оптимизирует работу систем охлаждения для снижения энергопотребления.

Аналитика на основе ИИ используется для прогнозирования перегрузок системы и вероятностей перегрева. Это позволяет новой платформе выполнять функции помимо прочего и системы раннего предупреждения, на которую могут положиться операторы ЦОД.

В настоящее время DeepMind использует данные, собранные в центрах обработки данных Google, чтобы сократить расходы на охлаждение в других ЦОД, что может привести к огромной экономии электроэнергии. В Google также надеются, что эта инициатива поможет снизить углеродный след дата-центров поискового гиганта и индустрии ЦОД в целом.

сравнение бытовых и прецизионных кондиционеров

Функционирование электрооборудования связано с выделением значительного количества тепла. В связи с этим система охлаждения помещений для серверов является важной частью их обустройства. При планировании кондиционирования учитывается, что мощность системы кондиционирования должна быть не менее пикового тепловыделения ИТ оборудования. Для безопасной работы характеристика должна превышать максимум мощности оборудования, находящегося в помещении на 20-40%.

В связи с этим система охлаждения помещений для серверов является важной частью их обустройства. При планировании кондиционирования учитывается, что мощность системы кондиционирования должна быть не менее пикового тепловыделения ИТ оборудования. Для безопасной работы характеристика должна превышать максимум мощности оборудования, находящегося в помещении на 20-40%.

Планирование системы охлаждения

При необходимости обустройства собственной серверной необходимо заранее решить какая система охлаждения будет установлена в помещении. Для серверных помещений, ЦОД выпускаются специальные прецизионные системы кондиционирования. На практике применяют для небольших серверных и обычные сплит системы для экономии капитальных затрат.

Бытовые или полупромышленные сплит-системы в большинстве случаев имеют мощность, не превышающую 10-15 кВт. Для работы электронного оборудования, пиковый параметр которого не превышает этот показатель такого охлаждения будет достаточно. Более мощные кондиционеры относятся к промышленному или коммерческому типу. Их стоимость при этом будет приближаться к цене прецизионных аналогов.

Их стоимость при этом будет приближаться к цене прецизионных аналогов.

Прецизионные кондиционеры предпочтительнее для снятия теплопритоков от оборудования, поскольку конструктивно имеют большую поверхность испарителя, чем бытовые. Это приводит к минимизации потерь энергии на конденсацию влаги из воздуха (полная холодопроизводительность почти равна явной). В результате при работе прецизионных кондиционеров в режиме охлаждения не происходит осушения воздуха, отрицательно сказывающегося на состоянии серверного оборудования.

Определяя вид системы охлаждения в серверной, необходимо учитывать и дополнительные условия:

- наличие отопительных коммуникаций;

- локацию помещения;

- присутствие другого оборудования;

- особенности помещения, ограничивающие отведение тепла.

При мощности сервера в 5 кВт достаточно будет установить бытовую сплит-систему с низкотемпературным комплектом для работы зимой в режиме охлаждения. В других случаях оптимально подобрать прецизионный кондиционер. При планировании увеличить количество серверного оборудования в будущем лучше устанавливать систему кондиционирования с запасом по мощности.

При планировании увеличить количество серверного оборудования в будущем лучше устанавливать систему кондиционирования с запасом по мощности.

Требования к кондиционерам в серверных

Некомпетентный выбор системы кондиционирования для серверной приводит к выходу из строя оборудования. Основные условия, которым должна соответствовать надежная система охлаждения:

- бесперебойная круглогодичная работа;

- функционировать в диапазоне наружных температур -30℃ – +45℃;

- наличие резервного кондиционера, автоматически включающегося при выходе из строя основного;

- возможность ротации оборудования для техобслуживания системы охлаждения.

Устанавливая систему охлаждения для серверной целесообразней заранее предусмотреть процесс техобслуживания оборудования. Режим остановки одного кондиционера для ТО и автоматического ввода другой системы охлаждения самый оптимальный. Наличие резервного устройства обойдется дешевле, чем ремонт дорогостоящего серверного оборудования.

Периодичность ТО систем охлаждения

Процедура техобслуживания кондиционеров, обеспечивающих работу серверов, заключается в своевременном проведении профилактических работ. Такой подход позволяет определить состояние узлов системы, выполнить замену изношенных деталей. В основном ТО проводится:

- ежемесячно;

- раз в квартал;

- каждые полгода.

Проведение работ по техобслуживанию системы охлаждения владелец серверной может назначить самостоятельно, без ущерба для производства.

Что такое жидкостное охлаждение серверов и зачем оно нужно

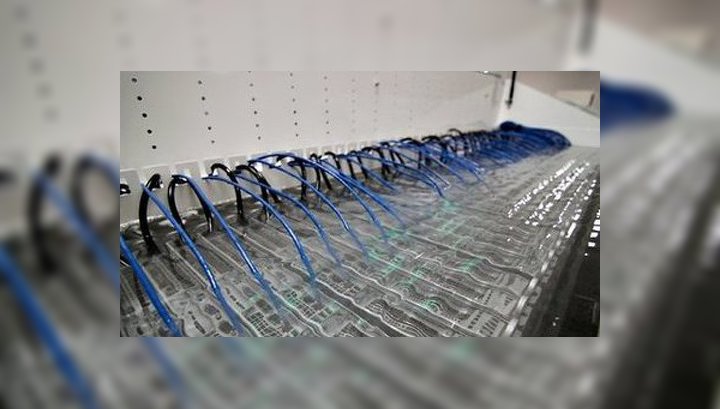

Тему жидкостного охлаждения за последние десять лет поднимают все чаще — тепловая нагрузка на серверные и ЦОДы растет, а самой распространенной технологией охлаждения все еще является климат-контроль и встроенные вентиляторы серверов, что не всегда эффективно.

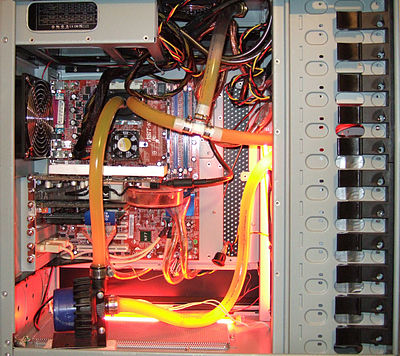

Технология, впрочем, не стоит на месте — сначала ведь речь шла о жидкости в кондиционерах, затем о подаче ее прямо в корпусы работающих компьютеров и, наконец, о погружении в охлаждающую жидкость работающих плат..png)

Все три варианта называются «жидкостным охлаждением», но наиболее радикальный из них, третий, вызывает больше всего надежд на будущее и применяется сегодня все чаще. Не парадокс ли это? Давайте разбираться.

Погружное жидкостное охлаждение

Жидкостное охлаждение, происходящее непосредственно в кондиционере, кажется логичным. Доставка жидкости в корпус работающего компьютера или сервера — рискованной. Но погружение в жидкость плат? С первого взгляда это по крайней мере странно, но на самом деле такой подход — самый «древний», его использовали еще в 1920-х годах для охлаждения высоконагруженного оборудования. Да и сейчас его можно встретить часто, просто в соответствующих устройствах: электротрансформатора высокого напряжения, электроподстанциях, конденсаторах.

Кроме того, использоваться для охлаждения погружением будет, конечно, не вода, а масло — как правило, белое минеральное масло, отличный хладагент с низкой вязкостью, высокой теплоемкостью, нетоксичное и экологичное. Кроме того:

Кроме того:

- Этот способ охлаждения дешевле. Хладагент можно поддерживать на уровне всего сорока градусов по Цельсию (воздух приходится охлаждать до 24), серверные вентиляторы задействовать больше не нужно — а это экономия до 20% электроэнергии, шедшей на сервер!

- Этот способ позволит плотнее располагать оборудование. Немалый вклад в дизайн корпусов Rackmount или Blade внесен необходимостью располагать в них вентиляторы — но теперь в них нет нужды. Зачастую даже в индивидуальных корпусах она пропадает.

- Погружное охлаждение делает работу оборудования более надежной. Пыль серверы собирать перестают, поломка вентилятора не будет причиной сбоя, температура распределяется по стойке равномерно — срок эксплуатации сервера увеличивается!

- После аварийных ситуаций вернуться в штатный режим проще, а иногда такие ситуации и не возникают: если у вас вышло из строя воздушное охлаждение, то оборудование перегреется за несколько минут, а если жидкостное, то процесс займет от 1 до 4 часов.

- Жидкостное охлаждение снижает вибрацию конструкции. Работающий вентилятор же производит такую вибрацию, что может даже приводить к ошибкам чтения и записи жестких дисков.

Конечно, не все так уж радужно, или все серверы уже давно были бы избавлены от корпусов и погружены в масло. Для установки такого охлаждения сервер придется модифицировать, обычные стойки, конечно же, не подойдут, а те, которые подойдут, очень массивны — займут больше места и будут больше весить (прикиньте сколько масла нужно на 42U!)

Последние несколько лет ведутся активные разработки оборудования, которое работало бы в таком вот новом форм-факторе — и так энергозатраты на охлаждение получается уменьшить на 90%, а общие энергозатраты — на 25%. В случае с центрами обработки данных это был бы существенный плюс к прибыли!

Однако главным противником широкого распространения масляного охлаждения является не это, а инерция рынка — даже обширные ЦОДы и корпоративные серверные, способные получить от такого перехода немалую прибыль, еще не приняли технологию как актуальную.

Создание массива RAID1 на базе контроллера Adaptec

22 Сентября 2017

ЧитатьМал да удал — HP MicroServer Gen10

28 Февраля 2019

ЧитатьКак улучшить работу IT-инфраструктуры, задав себе 6 простых вопросов

22 Августа 2019

ЧитатьКондиционер для серверной комнаты. Охлаждение серверной

Многие предприятия и организации выделяют под серверное и коммутационное оборудование специальные серверные комнаты. Казалось бы, всё сделано по правилам, но и тут может подстерегать проблема: оборудование начинает перегреваться, а это чревато многочисленными проблемами ― от снижения производительности до выхода сервера из строя.

Вот почему кондиционер в серверной ― это не роскошь, а необходимость!

В задачи кондиционеров для серверной комнаты входят:

Охлаждение воздуха в помещении с аппаратурой до оптимальной температуры и поддержание этой температуры.

Очистка воздуха от пыли.

Регулировка влажности воздуха в серверной.

Какие требования предъявляются к кондиционерам в серверной?

1

Здесь не устанавливают маломощные кондиционеры, они не способны обеспечить достаточное охлаждение серверных;

2

В кондиционерах должны быть смонтированы воздушные фильтры для задержки пыли;

3

Необходимо, чтобы в кондиционерах стояли так называемые «зимние комплекты» – они поддерживают постоянную температуру в серверной комнате даже при очень низкой или очень высокой температуре за окном.

На сегодняшний день мы готовы предложить Вам:

Лучшие цены на высококачественную продукцию известных мировых производителей систем охлаждения серверных помещений. Реализацию сложных, нестандартных проектов. Постгарантийное техническое обслуживание, ремонт и поставку запасных частей кондиционеров.Наша компания обладает богатым опытом реализации проектов кондиционирования воздуха на телекоммуникационных объектах и ЦОД. Мы в состоянии выстроить энергоэффективную систему любого уровня сложности и любой конфигурации, отличающуюся высочайшим уровнем надежности и безопасности.

Опираясь на этот опыт, мы находим то единственно верное решение, которое необходимо для конкретной задачи!

Команда инженеров-монтажников «СофтЭксперт» осуществляет полный комплекс услуг в области кондиционирования:

С помощью тепловизора составляем тепловую карту помещения, вычисляем рассеиваемую мощность серверного оборудования и на основе этих данных подбираем оптимальные мощность и место расположения кондиционеров;

Помогаем определиться с выбором из более, чем 300 моделей, исходя из индивидуальных требований.

Доставляем оборудование на объект, монтируем его и занимаемся профессиональным обслуживанием.

Все оборудование, которое мы вам предлагаем, сертифицировано и проходит тщательный выходной контроль перед отгрузкой.

Консультация, аудит, расчет стоимости проекта – бесплатны. Обращайтесь!

Контакты для связи:

- Телефон (многоканальный): (4872) 70-02-70; доб. 117

Губоненкова Ирина Львовна

Должность: руководитель отдела технического обслуживания

E-mail: [email protected]

Охлаждение серверной стойки: воздушный поток, вентиляторы и методы

Охлаждение сервера создает проблемы, уникальные для среды, в которой находится стойка. Серверные стойки предназначены для управления воздушным потоком и поддержания температуры в соответствии с рабочими характеристиками. Выбор правильного типа вентиляторов и их правильное размещение позволяет менеджерам центров обработки данных подавать холодный воздух из нужных мест и направлять горячий воздух туда, где он должен идти.

Серверные стойки предназначены для управления воздушным потоком и поддержания температуры в соответствии с рабочими характеристиками. Выбор правильного типа вентиляторов и их правильное размещение позволяет менеджерам центров обработки данных подавать холодный воздух из нужных мест и направлять горячий воздух туда, где он должен идти.

Управление теплом на сервере может помочь охладить комнату, снизить счета за электроэнергию или предотвратить сбой сервера.Как и в домашнем компьютере, у серверов есть воздухозаборники и вытяжки, через которые холодный воздух поступает с одной стороны, а горячий — с другой. Поскольку стойка по существу содержит несколько компьютеров, важно не только управлять потоком воздуха в каждом устройстве, но и в самой стойке.

Планирование отвода воздуха для серверной стойки выполняется таким образом, чтобы все оборудование могло перемещаться в холодном воздухе с одной стороны и выходить из стойки. Обычно это означает, что весь теплый воздух выдувается из задней части стойки и направляется вверх и наружу к потолку.Оттуда по обратным каналам теплый воздух может поступать в обратную камеру, где CRAH (кондиционер для машинного зала) охлаждает воздух и направляет его в охлаждаемые зоны. Кроме того, вентиляторы серверной стойки могут обеспечить направление воздушного потока во все нужные места.

Обычно это означает, что весь теплый воздух выдувается из задней части стойки и направляется вверх и наружу к потолку.Оттуда по обратным каналам теплый воздух может поступать в обратную камеру, где CRAH (кондиционер для машинного зала) охлаждает воздух и направляет его в охлаждаемые зоны. Кроме того, вентиляторы серверной стойки могут обеспечить направление воздушного потока во все нужные места.

Кассеты вентиляторов используются для отвода тепла из стойки и устанавливаются там, где может существовать горячая точка. Например, если наверху закрытой стойки нет оборудования, эта область может стать горячей из-за низкой циркуляции.Это то место, где вы разместите кассету с вентиляторами, чтобы заставить воздух двигаться и остановить избыточное тепло.

Горизонтальные стоечные вентиляторы также отводят тепло от сервера при возникновении горячих точек. Хотя вместо того, чтобы толкать воздух вверх или вниз, он выталкивает его из спины.![]() Это может быть лучше в ситуации, когда выталкивание воздуха вверх может привести к рециркуляции теплого воздуха обратно в охлаждаемую зону.

Это может быть лучше в ситуации, когда выталкивание воздуха вверх может привести к рециркуляции теплого воздуха обратно в охлаждаемую зону.

Если в сервере есть открытое пространство, вместо использования заглушек для заполнения пространства можно использовать вентилятор стойки для вывода воздуха из стойки.Тем не менее, заглушки отлично подходят для управления воздушным потоком и поддержания хорошей циркуляции.

Шум вентилятора в серверной стойкеПовреждение слуха может произойти уже при 85 децибелах, что примерно соответствует средней громкости в центре обработки данных. В центрах обработки данных лучший способ противодействовать шуму — хранить оборудование в разных комнатах, если только оно не должно быть вместе.

Уровень шума дома будет зависеть от качества оборудования, которое вы выберете для охлаждения стойки и серверной комнаты.Проверьте уровень децибел ваших поклонников, чтобы определить, насколько громко они будут звучать в вашей комнате. Если у вас несколько вентиляторов, децибелы не складываются линейно, поэтому вместо вентилятора на 70 дБ, работающего с другим вентилятором на 70 дБ, общая сумма будет около 73 дБ, а не 140 дБ. Поклонники с рейтингом около 30 дБ работают тише, а поклонники с уровнем шума более 65 дБ могут вызывать раздражение.

Если у вас несколько вентиляторов, децибелы не складываются линейно, поэтому вместо вентилятора на 70 дБ, работающего с другим вентилятором на 70 дБ, общая сумма будет около 73 дБ, а не 140 дБ. Поклонники с рейтингом около 30 дБ работают тише, а поклонники с уровнем шума более 65 дБ могут вызывать раздражение.Лучший способ снизить уровень шума сервера — использовать акустическую стойку. Они могут быть очень дорогими: даже стойка высотой 12U стоит около 4000 долларов.Цена связана с их способностью полностью охлаждать сервер, оставаясь при этом тихим. Некоторые из них доступны по более низкой цене, но имеют значительно меньше функций.

Системы отопления, вентиляции и кондиционирования воздуха Системы отопления, вентиляции и воздушного охлаждения включают в себя все оборудование, которое контролирует окружающую среду в доме или на предприятии. Поскольку серверные помещения выделяют тепло в помещении уникальным способом, эти системы могут стать очень дорогими. Как минимум, вам понадобится специальный блок переменного тока для вашего серверного блока и какой-то метод удаления отработанного воздуха.

Как минимум, вам понадобится специальный блок переменного тока для вашего серверного блока и какой-то метод удаления отработанного воздуха.

В центре обработки данных профессионалы используют фальшполы и очень высокие потолки для разделения горячего и холодного воздуха. Под полом воздух рециркулирует и проталкивается через напольную плитку в холодные коридоры. Выше потолка горячий воздух выталкивается в выхлопные трубы и в CRAH (кондиционер для компьютерного зала), который использует вентиляторы и охлажденную воду для отвода тепла.

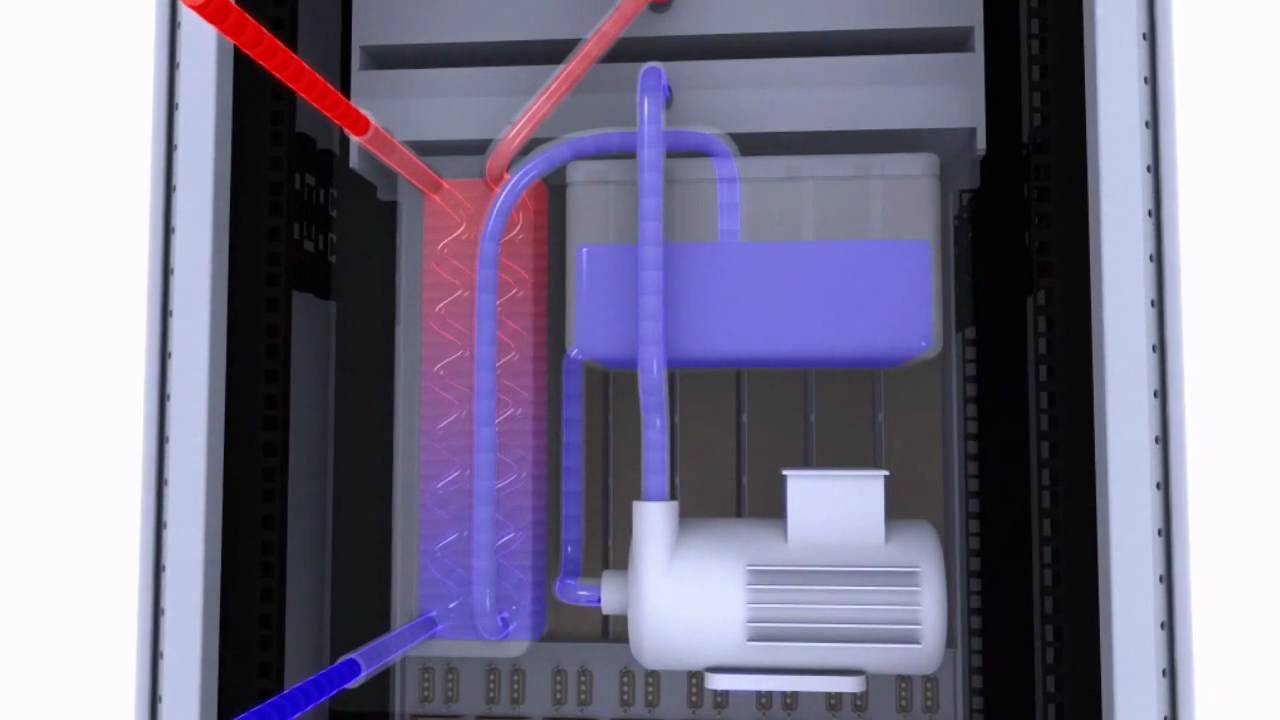

Жидкостное охлаждение для серверовЖидкостное охлаждение может быть чрезвычайно эффективным способом управления теплом в отдельных элементах оборудования или в серверной стойке в целом.Этот тип охлаждения работает путем перекачивания охлажденной жидкости на синхронизатор тепла. Эта синхронизация тепла передает тепло жидкости, которая затем перекачивается обратно в чиллер для повторного охлаждения.

С повышенной эффективностью приходит сложность. Жидкостное охлаждение сложно реализовать и в основном используется компаниями, которым требуется высокая производительность вычислений, такими как Google и фирмы, занимающиеся высокочастотной торговлей. Водяное охлаждение обеспечивает более высокую плотность процессорных блоков и, как следствие, большую мощность на одном сервере.На видео ниже вы можете увидеть, как Google собрал свою систему жидкостного охлаждения.

Жидкостное охлаждение сложно реализовать и в основном используется компаниями, которым требуется высокая производительность вычислений, такими как Google и фирмы, занимающиеся высокочастотной торговлей. Водяное охлаждение обеспечивает более высокую плотность процессорных блоков и, как следствие, большую мощность на одном сервере.На видео ниже вы можете увидеть, как Google собрал свою систему жидкостного охлаждения.

Для домашних или офисных серверов , вероятно, не будет экстремальных температурных требований. Более серьезной проблемой может быть минимизация затрат на электроэнергию, поэтому вы захотите протестировать различные методы, чтобы серверы не нагревали комнату. Это можно сделать, используя вытяжные вентиляторы на сервере, которые направляют вверх к вытяжной трубе потолка или из задней части в вытяжную трубу в стене. Убедитесь, что сервер заполнен оборудованием или заглушками, чтобы предотвратить рециркуляцию горячего воздуха в зону с холодным воздухом и наоборот.

Убедитесь, что сервер заполнен оборудованием или заглушками, чтобы предотвратить рециркуляцию горячего воздуха в зону с холодным воздухом и наоборот.

В серверной среднего размера , в идеале, у вас должны быть фальшполы и высокие потолки. В противном случае вы все равно можете использовать метод холодного и горячего прохода, но вам понадобится воздуховод, выводящий кондиционер в холодные коридоры, и занавес, защищающий переднюю часть серверов от горячего выхлопа, обеспечиваемого вентиляторами. Чтобы узнать о различных методах охлаждения конструкций, посмотрите это информационное видео.

Центры обработки данных , которым важны высокопроизводительные вычисления, могут выбрать систему жидкостного охлаждения. Если они выберут воздушное охлаждение, все здание с самого начала будет построено вокруг серверов, поэтому у них, вероятно, будут фальшполы для охлаждения, место в потолке для выхлопных газов и современное оборудование HVAC, способное выдерживать огромное количество тепла.

Сводка

Название статьи

Охлаждение серверной стойки: воздушный поток, вентиляторы и методы — RackSolutions

Описание

От воздушного до жидкостного охлаждения существует множество различных методов охлаждения вашего сервера, обеспечивающих максимальную производительность при минимуме Стоимость

Автор

Патрик Клис

Имя издателя

RackSolutions

Логотип издателя

Охлаждение в стойке в серверных залах и центрах обработки данных

Решения для охлаждения в стойке высокой плотности для серверных стоек, компьютерных комнат и центров обработки данных

Существующим центрам обработки данных часто не хватает мощности и мощности охлаждения для поддержки оборудования сегодняшнего и завтрашнего дня.Несмотря на этот недостаток, организации могут не иметь капитальных ресурсов для проектирования и строительства нового объекта. Для решения этих проблем 42U предлагает жизнеспособное решение, которое дает устаревшим центрам обработки данных новую жизнь: охлаждение в стойке с высокой плотностью размещения.

Что такое охлаждение в стойке?

In-Rack — это наиболее точное охлаждение из имеющихся, поскольку стойка и кондиционер работают в тесном взаимодействии друг с другом. Холодному воздуху ничего не остается, кроме как проходить через серверы; у горячего воздуха нет другого выбора, кроме как проходить через теплообменник.

Охлаждение In-Rack обеспечивает вычислительную среду — микроклимат, — который термически нейтрален по отношению к остальной части комнаты.

Высокая плотность, высокая эффективность

Как и его родственная стратегия (охлаждение в ряду), охлаждение в стойке выгодно за счет расстояния. Пути воздушного потока небольшие, что требует меньше энергии вентилятора. Кроме того, отработанный воздух улавливается в самой горячей точке, максимально увеличивая дельту Т охлаждающего змеевика.

Пользователи, знакомые со стратегиями сдерживания, могут рассматривать охлаждение в стойке как полностью развитую систему сдерживания: и горячий, и холодный коридоры в одном месте.

Охлаждающая среда

При охлаждении в стойке, в зависимости от продукта, в качестве охлаждающей среды используется охлажденная вода или хладагент. Хотя есть исключения, большинство продуктов не доставляют жидкость в фактическую серверную стойку. Кондиционер с подключением к воде размещен в соседнем, но отдельном корпусе. Оборудование на уровне стойки по-прежнему охлаждается воздухом.

Для агрегатов с охлажденной водой потребуется подключение к чиллерам для подачи охлажденной воды и окончательного отвода тепла.

Вентиляторы для стоек и блоки вентиляторов для монтажа в стойку

Для стоек с меньшей плотностью вентиляторы могут быть жизнеспособным решением для усиления охлаждения, облегчая движение окружающего воздуха через стойку. Вентиляторы могут быть установлены на крыше, по бокам и дверям или могут быть встроены непосредственно в стойку в виде выдвижных кассет вентиляторов. Для повышения эффективности любых вентиляторов рекомендуется надлежащее управление воздушным потоком за счет использования заглушек и герметизирующей ленты.

Доступны как вентиляторы шкафа в сборе, так и вентиляторы для монтажа в стойку сверху и снизу.Хотя однофазные вентиляторы 115 В являются наиболее распространенными, многие устройства доступны с различным напряжением, в конфигурациях переменного или постоянного тока.

Модель 42U Advantage

42U убедилась в преимуществах охлаждения в стойке на собственном опыте. Наша база инсталляций варьируется от небольших компьютерных залов до корпоративных центров обработки данных и коммутационных шкафов с высокой плотностью размещения — различных сред, которые явно более масштабируемы и эффективны, чем их предыдущие жизни.

Эти уникальные среды требуют одинаково уникальных знаний продукта и опыта применения.Позвоните 1-800-638-2638 , чтобы поговорить со специалистом по продукту.

Более 55 000 компаний-клиентов выбрали 42U

Не зря мы выбираем № 1 среди многих ИТ-специалистов.

Вопросы? Звоните нам.

Позвоните и поговорите с одним из наших знающих инженеров по решениям, который ответит на любые ваши вопросы.

1-800-638-2638

Запросить оценку

Один из наших специалистов по решениям для центров обработки данных будет работать вместе с вами, чтобы найти оптимальное решение для вашей системы.

Запросить оценку

Что следует знать о технологиях охлаждения центров обработки данных

Средний центр обработки данных потребляет довольно много электроэнергии. Это не должно вызывать удивления, учитывая количество вычислительных мощностей, которые им удается разместить на одном информационном этаже, не говоря уже об инфраструктуре охлаждения, необходимой для поддержания идеальной операционной среды для всего этого оборудования. В совокупности центры обработки данных потребляют около трех процентов мировой электроэнергии.В связи с появлением в ближайшие годы большего количества энергоемких гипермасштабных объектов потребление энергии, вероятно, продолжит расти, несмотря на повышение эффективности.

Быстрые ссылки

Для заказчиков колокации важно понимание характеристик питания и охлаждения инфраструктуры центра обработки данных, поскольку это помогает им лучше оценить свои потенциальные затраты и будущие вычислительные потребности. Например, схема энергоснабжения центра обработки данных может оказать серьезное влияние на то, как компания решит увеличить свои мощности.К счастью, возможности центра обработки данных по питанию и охлаждению, как правило, относительно легко оценить.

Например, схема энергоснабжения центра обработки данных может оказать серьезное влияние на то, как компания решит увеличить свои мощности.К счастью, возможности центра обработки данных по питанию и охлаждению, как правило, относительно легко оценить.

Энергопотребление центра обработки данных

Оценка требований к электропитанию — одна из первых задач, которую должна выполнить любая организация, когда она решает переместить активы в центр обработки данных. Потребляемая мощность оборудования обычно составляет значительную часть затрат на размещение, и развертывание мощных серверов в шкафах с высокой плотностью размещения будет дороже, чем сопоставимое количество менее впечатляющих устройств.Независимо от типа используемых серверов, им также потребуются блоки распределения питания (PDU), способные выдерживать большую силу тока, которую они потребляют во время использования.

Электрическая система центра обработки данных должна включать в себя некоторый уровень резервирования, который включает системы бесперебойного питания (ИБП), аккумуляторные батареи и резервный генератор, который может обеспечить достаточную мощность в мегаваттах для поддержания работы объекта в случае отключения основного питания в течение любого периода времени. В случае отключения электроэнергии системы ИБП будут поддерживать все вычислительное оборудование в рабочем состоянии достаточно долго, чтобы генератор мог выйти в оперативный режим.Во многих случаях инфраструктура электроснабжения центра обработки данных включает в себя несколько линий электропитания, подключенных к объекту, что обеспечивает дополнительное резервирование.

В случае отключения электроэнергии системы ИБП будут поддерживать все вычислительное оборудование в рабочем состоянии достаточно долго, чтобы генератор мог выйти в оперативный режим.Во многих случаях инфраструктура электроснабжения центра обработки данных включает в себя несколько линий электропитания, подключенных к объекту, что обеспечивает дополнительное резервирование.

Colocation также имеют четко определенные характеристики электропитания, в которых указано, сколько мощности они могут подать на каждый шкаф. Для развертываний с высокой плотностью размещения заказчики должны найти инфраструктуру центра обработки данных, способную обеспечивать от 10 до 20 кВт мощности на каждый шкаф. Хотя компании с гораздо более низкими потребностями в электроэнергии могут не беспокоиться об этих ограничениях на начальном этапе, им всегда следует иметь в виду, что их требования к мощности могут со временем увеличиваться по мере роста.Масштабирование операций в среде центра обработки данных с учетом схемы электропитания часто предпочтительнее, чем хлопот по переходу на совершенно другой объект.

Как охлаждаются центры обработки данных?

В традиционных методах охлаждения центра обработки данных используется комбинация фальшполов и инфраструктуры кондиционирования воздуха в компьютерном зале (CRAC) или обработчика воздуха в компьютерном зале (CRAH). Установки CRAC / CRAH будут создавать давление в пространстве под фальшполом и проталкивать холодный воздух через перфорированные плитки в воздухозаборники серверов.Как только холодный воздух проходит через компоненты сервера и выходит наружу в виде горячего выхлопа, этот воздух возвращается в CRAC / CRAH для охлаждения. Большинство центров обработки данных установили бы температуру возврата блока CRAC / CRAH в качестве основной контрольной точки для всей среды цеха обработки данных.

Проблема с этим развертыванием в том, что оно неэффективно и не имеет точного контроля. Холодный воздух просто попадал в серверную. Хотя это работало достаточно хорошо для небольших развертываний с низкой плотностью и низким энергопотреблением, это работало хуже для больших площадей данных с более высокой плотностью. Вот почему большинство предприятий приняли стратегии сдерживания горячего и холодного проходов, чтобы физически отделить холодный воздух, предназначенный для впуска сервера, от горячего воздуха, выходящего через его вытяжные отверстия. Предотвращение смешивания этого воздуха обеспечивает более стабильную температуру и максимизирует эффективность, гарантируя, что холодный воздух остается холодным, а горячий воздух направляется в устройства обработки воздуха без повышения температуры окружающей среды.